Сервер лежит у меня с 13:30 ответа от тех.поддержки нет.

Уважаемые сотрудники clodo.ru где вы? Где письмо/сообщение тикета/etc ваше обращение почему и сколько мы должны лежать?

UPDATE 15 июня. Компенсации.

Сегодня один хабра пользователь прислал очень интересное сообщение о его попытке получить компенсации:

11:55:22 14.06.2011 Я пишу:

Добрый день.

У нас не работает VPS 11111-1, уже 4 дня.

В чем проблема? Когда будет работать сервер?!

11:56:55 14.06.2011 Служба поддержки (Александра М*шук***) пишет:

Сервер уже четыре дня в состоянии «обработка запроса»?

12:01:42 14.06.2011 Служба поддержки (Александра М*шук***) пишет:

Проверьте сейчас. По ssh доступен, работает.

14:23:25 14.06.2011 Я пишу:

Теперь доступны. В чем была проблема?

14:27:27 14.06.2011 Служба поддержки (Александра М*шук***) пишет:

Проблема была с нашей стороны. Приносим извинения за неудобства.

потом узнал про компенсации:

Здравствуйте.

Согласно договору публичной оферты в редакции от 23 мая, выплата компенсаций осуществляется только при заключении с Clodo договора об отказоустойчивом обслуживании. К сожалению, мы вынуждены отказать вам в выплате компенсаций. Мы очень сожалеем о произошедшем инциденте. Мы сделали все, чтобы ничего подобного в будущем не повторилось. Если вас интересует решение высокой доступности, развернутое в двух дата-центрах, мы сможем предоставить его в течение месяца.

Клодо, клодо, вы всё в своём репертуаре, никому ничего мы не должны у нас на всё есть оправданияотмазки… Кстати передайте своему юристу по закону смена условий предоставление услуг вашей офёрты должна быть с уведомлением не менее за 5 рабочих дней, если иного не указано в договоре. Сотрудники клодо вам самим то не стыдно в такой компании работать?

UPDATE 14 июня: Прошло 4 дня.

Разъяснения по аварии 10.06.2011

Как вы знаете, Clodo ведет работы по изменению структуры управления кластером. Учитывая весь печальный опыт, ведем мы их ночами и разбивая на атомарные недеструктивные действия.

В ночь перед инцидентом наши инженеры производили работу по исключению из кластера одного из InfiniBand-свичей. С одной стороны, это действие было подвергнуто предварительному тестированию, с другой – по его завершении было еще раз проверено, что ничего не было нарушено. После этого никаких работ не производилось.

Однако, через весьма продолжительное время началось падение виртуальных машин. Проблема возникла из-за сбоя драйвера IP over Infiniband (IPoIB) в работе с Suse Linux Enterprise Server, установленном на наших XEN-нодах, контроллере кластера и на релеях. К сожалению, сбой был достаточно фатальным и виртуальные машины поднимались не автоматически, а вручную. Более того, в скрипты запуска пришлось вносить экстренные изменения, поэтому подъем виртуальных машин произошел не так быстро, как хотелось бы. У небольшой части (10-15) виртуальных машин в результате сбоя пропала связь между виртуальной машиной и диском. Работоспособность этих машин пришлось восстанавливать дольше.

Сбой произошел по нашей вине. Основные ее составляющие:

недостаточное тестирование перед проведением операции (не были исключены отложенные по времени ошибки);

не до конца протестированное взаимодействие Suse Linux Enterprise Server и Infiniband;

недоработанные на случай аварии такого рода скрипты запуска.

Все эти ошибки являются следствием человеческого фактора. Виновные отстранены от осуществления любых действий на production-серверах.

Небольшой FAQ

Почему служба поддержки отвечала так медленно?

Ответ простой: в момент аварии нагрузка на службу технической поддержки возрастает многократно. Служба поддержки была подключена к устранению аварии: составляла списки пострадавших, мониторила запуск после устранения проблем, всячески помогала системным администраторам.

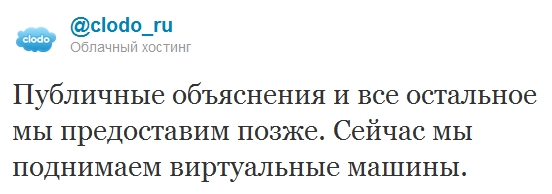

Почему во время аварии со мной не общались на форуме / «Хабрахабре» / Twitter и не рассказали, что происходит

Все люди, способные точно понять и объяснить, что происходит, занимались устранением последствий. Тратить время людей, решающих проблему, было крайне нецелесообразно.

Повторится ли что-нибудь подобное?

На данный момент все работы приостановлены. Единственное, что делается — восстановление отключенной на время работ функциональности. Утвержден новый регламент подготовки к работам, включающий в себя тестирование работоспособности всей системы в целом после любых планируемых изменений ее узлов.

От себя лично хочу извиниться перед теми, кому я не ответил на сообщения, которые Вы присылали на мой почтовый ящик. Я не успеваю физически обрабатывать такой поток писем.

Генеральный директор Clodo,

Максим Дюбарев

От себя хочу сказать, Вы действительно Максим думаете что это достойное объяснение… Хотя о чём я говорю, как вы дела ведёте, так и объясняетесь. Сами себе только хуже сделали.

UPDATE 19:45: у меня оставшиеся 2 сервера на разных акаунтах работают.

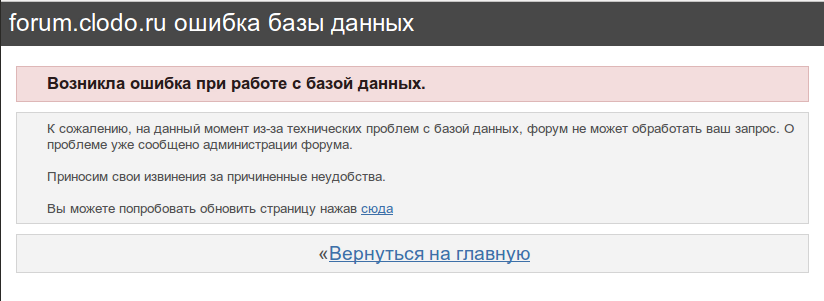

UPDATE 19:15: история продолжается. Я уже съехал главным проектом, но судя по комментариям проблемы всё ещё есть. На данный момент форум клодо выглядит так:

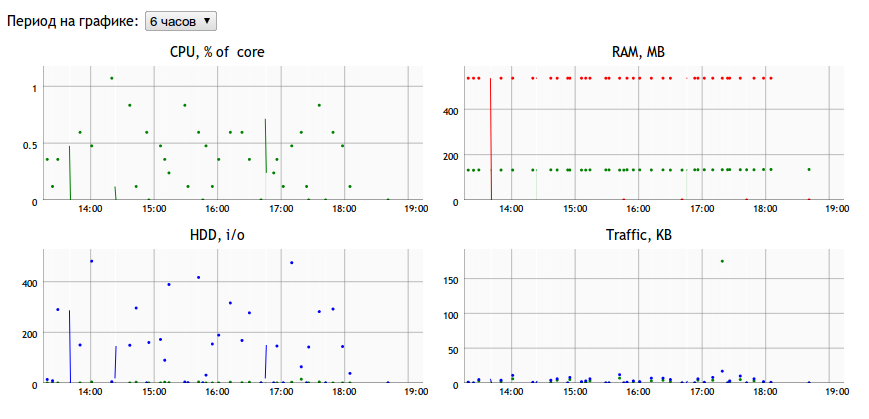

А графики работы одного из моих серверов за последние 6 часов так:

Вы уходите и даже не попрощаетесь?

UPDATE 07:10: более 18 часов. Все сервера поднялись. Пора переезжать! Видимо сотрудники клодо уже пришли на работу, хорошенько выспались и включили сервера :)

UPDATE 04:30: более 15 часов. Хотелось бы потом увидеть пофамильно ответственных за падение. Почти 5 часов утра, я жду пока поднимут сервера, чтобы забрать последние актуальные бэкапы. Но что-то мне подсказывает, что сотрудники клодо уже давно ушли спать по домам…

UPDATE 02:00: 13 часов лежим. Уважаемые сотрудники клодо, это просто распиздяйство и неуважение к клиентам! Я надеюсь после этого падения от вас съедут все или большинство. За все ваши простои по всем серверам потеряно денег больше, чем стоит весь ваш хостинг! Более того, подорвана репутация одного проекта, которую не за какие деньги теперь не восстановить, я делал компенсации и бонусы сколько мог своим пользователям за каждое ваше падение. Что мне теперь делать не представляю.

Ваш облачный сервис больше ничего не стоит с таким uptime. Сказать что я вас ненавижу это ничего не сказать. Ещё раз благодарю за ваше качество и отношение.

UPDATE 23:00: 10 часов лежим. Нет, ну это уже перебор господа. Всё настолько отказоустойчивое, что вы 10 часов не можете поднять.