Я не являюсь экспертом, а просто администрирую небольшую сеть, я как любой человек допускаю ошибки, потому описываю все не так как оно правильно должно было бы быть, а как оно было на самом деле. Так что некоторые «ляпы» допущенные мной за время проделанной работы прошу не рассматривать слишком строго.

Введение

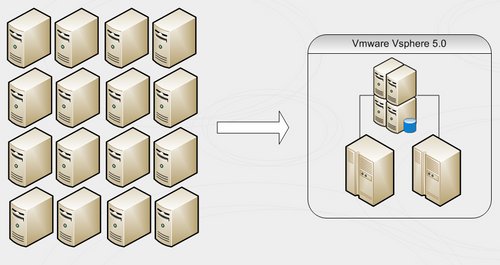

На дворе 2012 год. Я уже три года работаю в бюджетной организации под названием муниципалитет города Томска. Если первые полгода пришлось разбираться и «въезжать» в структуру организации сети и «что» и «откуда» растет с точки зрения сетевого оборудования, то последние 2.5 года пришлось потратить на поддержку серверного «хозяйства». А его как оказалось совсем чуть-чуть: лес состоящий из 25 доменов, на каждый 1-2 контроллера + 1-2 файл-сервера + сервер с БД + роутер если подразделение подключено через стороннего провайдера (часто роль первых трех выполнял один сервер, но об этом позже). И так сложились обстоятельства, что оборудование имеет привычку стареть. При этом в последний раз покупка оборудования была в 12.01.2007 – два «новых» сервера уже заметно постарели (5 лет прошло). А выделение новых средств хватало исключительно на поддержку старых серверов, а именно зип-пакета из винчестеров на случай если один в рейде выйдет из строя. На мой постоянный вопрос: «А что мы будем делать, если накроется сама плата рейда?» бывалые администраторы разводили руками. Однако время шло, нештатных ситуаций было все больше, случалось и так, что за ночь вылетали и по два винчестера в одном рейде. Мы (коллектив комитета информатизации администрации города Томска) понимали, что надо что-то менять. Или старые сервера на новые или смотреть в сторону виртуализации.

VMWARE. Знакомство

Знакомство с vmware случилось впервые у меня на 3 курсе (2004) когда я пошел работать в местную контору TOMLINE (Zmodem, evg33 – спасибо Вам) именно там я в первый раз в жизни поставил vmware workstation для того чтобы побаловаться с linux и freebsd и ничего не поломать на работающих серверах. Тогда жутко не хватало ни процессора ни памяти – и выглядело очень уныло и не перспективно. Проводя аналогию могу сказать что приблизительно так же я познакомился с windows 3.11 когда в 5ом классе запускал его из Norton Commander`а смотрел на «окна» запускал в них paint, а потом закрывал и продолжал использовать в качество основной ОС – DOS, все мы знаем где сегодня DOS, а где Windows =). Однако время шло, на дворе был далекий 2009, начались конференции и вебинары посвященные виртуализации. Первые опыты внедренные в работу существующей сети я ставил на vmware Infrastructure – бесплатная софт от vmware, который ставится поверх windows в которой можно разворачивать виртуальные машины и она «умеет VLAN`ы». Дальше больше, большую роль сыграл бесплатный вебинар от Максима Мошкова (я до сих пор не могу понять lib.ru – его проект?). Впервые доступным языком рассказали, а главное показали, что такое HA, Failover, DRS и т.д. и вживую продемонстрировали, как оно работает и ответили на все мои вопросы (очень часто приходится посещать семинары, где менеджеры-продавцы много рассказывают по слайдам-заготовкам, когда же спросишь чуть в сторону – ответить ничего не могут, если это читают представители vmware: пожалуйста, выделяйте тех специалиста для таких презентаций).

VMWARE: Внедрение

Конец 2009 выдался довольно интересным. В результате вступления в должность нового мэра весь аппарат мэрии (большая его часть) перешел на мобильные устройства. Если раньше все что было нужно это ноутбук с интернетом и покупка wi-fi точек на каждый этаж полностью решала все проблемы и потребности, то с приходом нового руководства требования «немножко» подросли: электронный документооборот должен был работать на всех мобильных платформах: windows mobile (коммуникаторы), iOs (айфоны уже были и немного позже появится ipad), symbian (по прежнему есть любители NOKIA) — и все это должно работать и поддерживать корпоративную почту и разумеется «надо еще вчера». Именно тогда я в первый раз столкнулся с нехваткой серверов. Сервис нужен. Сервера нет. Зашли мы в серверную – подумать. Вижу контроллер домена – все как надо на отдельной железке, рядом сервер под оракл – собирает статистику посещения муниципального сайта. Ну и пришла в голову идея виртуализировать эти два сервера. И вот свежепоставленный esxi 4.0 зарегистрированный на сайте vmware стоит в нашей сети. Как известено одинокостоящий гипервизор после регистрации – бесплатен и это хороший маркетинговый ход. Так в администрации города Томска появился первый гипервизор на базе vmware.

Выбираем VMWARE

Если сегодня для меня выбор бренда для виртуализации очевиден, то в 2010 были очень большие дебаты: vmware, xen, hyper-v. Особо крупно эти дебаты развернулись, когда впервые стали возникать вопросы по приобретению площадки для виртуализации, а главное о выделении средств на эту площадку. Каким-то «магическим» образом об этом узнали крупные поставщики серверного железа из соседних городов и начали предлагать и продвигать свои решения. Тут стоит отметить настойчивость microsoft: они молодцы, в далеком сибирском городе про них рассказывали все чаще. Много кто рекламировал hyper-v, но при этом постоянно было слышно: вот-вот и мы догоним vmware – про vmware тоже было слышно многое, но в основном из вебинаров. А вот то, что касается XEN – то тут провал, очень мало информации (в то время). Я честно поставил hyper-v, но как оказалось в 2010 он плохо работал с freebsd, а именно эта операционная система использовалась на серверах находящихся в DMZ нашей сети, которую так же планировалось виртуализировать (при этом посещение семинара «облака без бла-бла-бла» от microsoft 11 апреля 2012 года так же показало небольшое отставание microsoft от своих коллег их vmware, семинар начался со слов: «Ну вот мы и догнали vsphere 5.0 в своем новом windows server 8» дальше идут цифры-цифры-цифры, но оказывается что релиз будет то ли в октябре, то ли в ноябре, а грузится с хранилища оно так и не умеет – если честно, я не понимаю, почему? Я может субъективно смотрю на вещи, но когда вы покупаете хранилище, которое как правило дороже любого сервера и у вас разумеется есть для неё поддержка и запасные винчестеры, зачем использовать локальные винчестеры на хостах? Для чего? Непонятно. Так же были попытки изучать KVM, но отсутствие клиента под windows было первым неудобством, которое сразу не понравилось. Итак – VMWARE: все бы хорошо, но вот цена… При самых скромных подсчетах лицензия получалась в районе 500 000, но в ней не было бы никакого смысла, если нет хранилища и двух идентичных серверов-хостов для организации отказоустойчивого кластера.

Внедряем по чуть-чуть

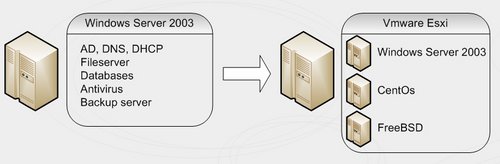

Так сложились мои должностные обязанности, что в первую очередь я должен был отвечать за работоспособность леса доменов в Active Directory. Когда я пришел на работу то обнаружил порядка 8 «забытых» контроллеров и 2 «не нужных» домена. И если в головном домене (если так можно сказать) все вроде было хорошо, то ошибки в журнал службы каталогов сыпались ежедневно. После исследования причин возникновения некорректно удаленных контроллеров домена, стало ясно: проблемы начинаются, когда на контроллер домена вещают задачи, которые он не должен выполнять. Логично разнести контроллер домена, резервный контроллер, файловый сервера, антивирус и т.д. по разным серверам, но как это сделать, если имеется всего один физический сервер? Вот тут на помощь и приходит vmware со своим гипервизором esxi: на одном физическом сервере мы запускаем столько операционных систем сколько нужно, однако по прежнему зависим от «железа». Если случится что-нибудь с рейд массивом, памятью, материнской платой, то возникнет определенное время простоя и так как контроллер домена будет не доступен, возникнут определенные сложности. Возник вопрос о создании выделенного сервера под резервные контроллеры на базе esxi.

Так устроено большинство корпоративных сетей (сеть администрации города Томска – не исключение), что каждое подразделения приходит по своей оптике и живет в своей подсети (в своем VLAN`е). Если в головной структуре организовать сервер на esxi с виртуальными машинами и прокинуть туда существующие VLAN`ы, то будет возможность создать по резервному контроллеру домена, о котором некоторые «местные» администраторы даже не узнают, которые будут находится в тех же подсетях что и основные контроллеры. В этом случае, если что-то случается с основным контроллером (как показывает практика то стабильно раз в месяц в одном домене да случается), то пользователи авторизуются на втором, всегда есть возможность развернуть ДХЦП, ну а если совсем все плохо с основным (сгорела материнская плата – такое у нас было), захватываем роли и вычищаем ntdsutil`ом данные о старом сервере. В любом случае, это проще чем создавать новый домен с нуля и ходит добавлять компьютеры в новый домен и т.д. (и такое у нас было). Собственно развернуть отдельный esxi хост и поднять на нем такие «резервные контроллеры» получилось довольно быстро. Он стабильно работает уже год и все к нему привыкли.

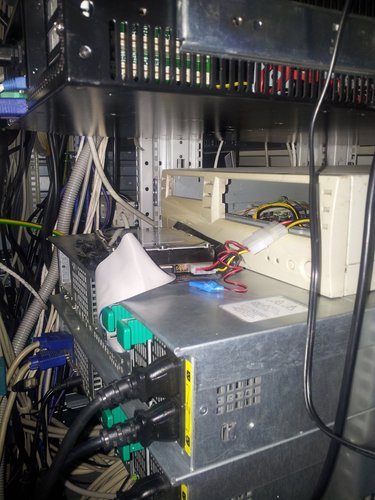

Отдельно стоящий хост – это замечательно. Но хотелось увидеть все прелести High-Availability. И если сферу (vmware vsphere) можно было использовать в течение 60 дней, то где взять хранилище? Тут на помощь приходит freenas и iscsi. В принципе хорошее решение, но добиться от него стабильности и высокой производительности так и не получилось. Не буду вдаваться в подробности, статья не про это. Проблемы начались в ноябре 2011. На каждых выходных (делаются бекапы, повышается дисковая активность), начали «некорректно» работать рейд-массивы: то винчестер в оффлайн уйдет, то загружается только с 3 раза. Проблемным был один из винчестеров, но пока его вычислили, нервов попортили не мало. А когда это происходит на главном файловом сервере, то это особенно грустно. А тут еще и «кризис места»: нужно бекапить 500 Гб, а некуда. Вот и приходится подключать к серверу внешний IDE винчестер, но из-за отсутствия IDE-шного питания пришлось держать его с открытой крышкой и запитать от обычного компьютера. Что дало перегрев винчестеров, которые не охватывались вентиляторами. Пришлось вынимать пластину закрывающую слот расширения, и протянуть IDE шлейф через образовавшееся окошко. Крышку закрыли, IDE винчестер сверху, температура винчестеров в сервере упала, глюки прекратились. И все это в ожидании нормального хранилища.

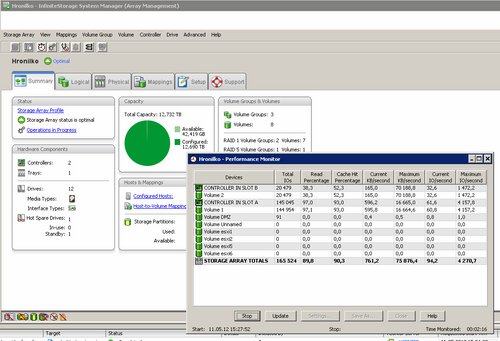

Летом 2011 года: в рамках целевой программы появляется возможность обновить серверное оборудование. Провели два аукциона и приобрели один мощный сервер и хранилище. И заложили в бюджет 2012, что в январе будет еще один аукцион на второй такой сервер, а во втором квартале покупаем, снова через аукцион программное обеспечение для виртуализации. Кстати благодаря аукциону сэкономили 9,5% от начальной цены. В результате всё успешно получено и запущено в марте 2012.

Железо

В итоге мы получили:

Сервера

Платформа Intel 1U SR1695WBA (LGA1366, i5500, PCI-E, SVGA, SATA RAID,4xHotSwapSAS/SATA, 2xGbLAN, 8DDR-III, 2*450W); Intel Xeon X5675; 64 GB RAM – 2 шт

Контроллеры:

LSI Logic Host Bus адаптер SAS 9205-8e SGL (LSI00285) – 2 шт

Qlogic iSCSI Dual Prt PCIe HBA – 3шт

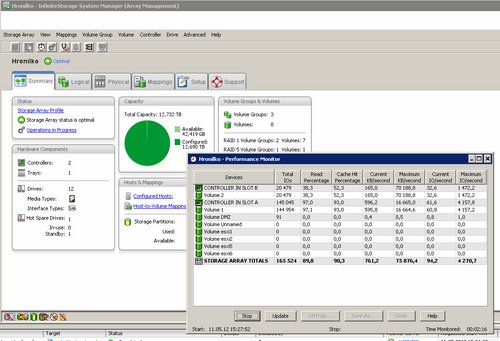

Система хранения данных

LSI Server ACC DRIVE CHASSIS/CDE 2600-12 со встроенным iSCSI и Raid контроллером LSI SERVER ACC Raid ISCSI SAS CRU/2600 2 Gb M102248 — 1 шт

SERVER ACC HDD 2TB 7.2k SAS/44354-00 M102349 PACL LSI – 12шт

Идея: все высоконагруженные сервера перенести на отказустойчивый кластер состоящий из двух хостов (два новых сервера) которые будут подключены к хранилищу по SAS освободившееся сервера (поновее, у которых есть PCIe слот) подключить к хранилищу по iscsi (еще 4 сервера). Как видно на оптику денег не хватило, а SAS вроде как должен устраивать. При этом LSI заявил о выходе SAS HBA свитча, который позволит подключить еще больше серверов к хранилищу по SAS.

Из 3 заказанных iscsi плат полностью рабочей оказалась только одна!!! Одна стразу не увидела хранилище, вторая как выяснилось позже, не дает грузиться с хранилища.

HBA SAS пришли на месяц позже. Они заработали без каких-либо проблем. На данный момент пока три хоста грузятся с хранилища. Ждем пока заменят по гарантии QLogic-и

Выводы

В результате внедрения VMWARE vSphere 5.0 в корпоративной сети муниципалитета г. Томска можно сделать следующие выводы:

1. Повышена отказоустойчивость работы критически важных серверов за счет создания High-Availabilty кластера.

2. Возможность живой миграции позволяет проводить регламентные работы без прекращения работы критических серверов.

3. Сокращение потребления электропитания с 5,3 кВт/ч до 3,8 кВт/ч (экономия 60 000 рублей в год).

4. Удобство администрирования: единая консоль управления, нет «привязки» к железу.

В общем если у вас 3 и более отдельно стоящих серверов, то виртуализировать несомненно стоит.

VMWARE: PSOD к нам приходит

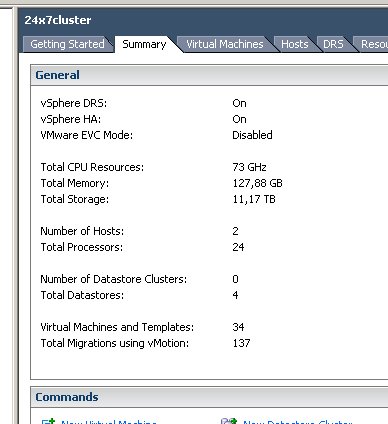

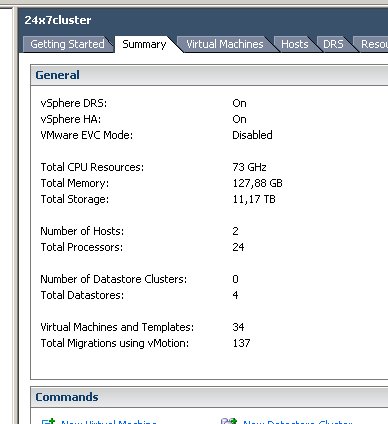

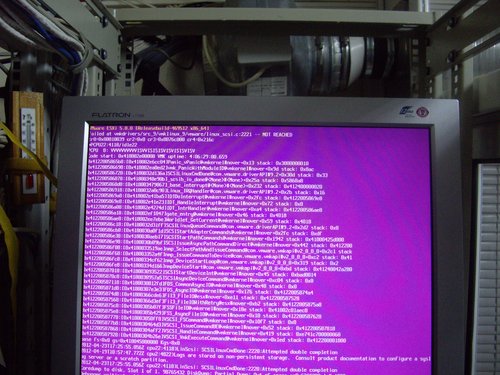

Все настроено и работает. В результате миграции выключили 6 старых серверов. В планах еще 5. Удобство миграции виртуалок, которых уже 34 не может не радовать. Вообще виртуализации сильно расслабляет – но безусловно упрощает жизнь администратора. И пришел вторник 24 апреля 2012. Как обычно прихожу на работу и вижу аларм от Nagios, что один из хостов не доступен. Монитор же показал мне вот такую картину:

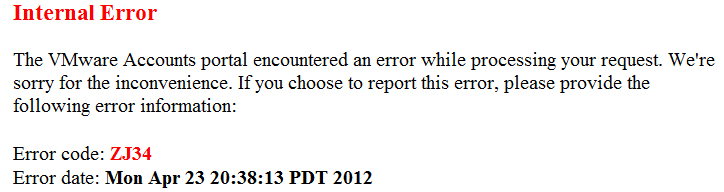

Немножко гугла и все в принципе ясно communities.vmware.com/thread/311457?start=0&tstart=0 (вообще база знаний vmware радует, чего не скажешь про их download center). Но у нас же обязательная поддержка. По условиям Vmware поддержка осуществляется только после регистрации продукта: ок, регистрируемся. Получаем еще один интересный скриншот.

Связываемся с поставщиками, нам рекомендуют отписать на почту: vi-hotline@vmware.com

Пишем письмо. Получаем ответ.

Thank you for requesting support from VMware Licensing Support. Your Support Request Number is 12167833904

A Licensing Support Specialist will respond to your query within 12 hours.

Сейчас 12 часов прошло, но ответа не последовало. А жаль. Ну вот в принципе и все. Сейчас утро 25 апреля. И этот скромный очерк об опыте внедрения VMWARE vSphere 5.0 на примере муниципалитета г.Томска подошел к концу. Если у Вас есть вопросы, предложения, желание обменяться опытом – пишите gtt@admin.tomsk.ru постараюсь ответить всем. Спасибо, что прочли эту статью до конца.

Введение

На дворе 2012 год. Я уже три года работаю в бюджетной организации под названием муниципалитет города Томска. Если первые полгода пришлось разбираться и «въезжать» в структуру организации сети и «что» и «откуда» растет с точки зрения сетевого оборудования, то последние 2.5 года пришлось потратить на поддержку серверного «хозяйства». А его как оказалось совсем чуть-чуть: лес состоящий из 25 доменов, на каждый 1-2 контроллера + 1-2 файл-сервера + сервер с БД + роутер если подразделение подключено через стороннего провайдера (часто роль первых трех выполнял один сервер, но об этом позже). И так сложились обстоятельства, что оборудование имеет привычку стареть. При этом в последний раз покупка оборудования была в 12.01.2007 – два «новых» сервера уже заметно постарели (5 лет прошло). А выделение новых средств хватало исключительно на поддержку старых серверов, а именно зип-пакета из винчестеров на случай если один в рейде выйдет из строя. На мой постоянный вопрос: «А что мы будем делать, если накроется сама плата рейда?» бывалые администраторы разводили руками. Однако время шло, нештатных ситуаций было все больше, случалось и так, что за ночь вылетали и по два винчестера в одном рейде. Мы (коллектив комитета информатизации администрации города Томска) понимали, что надо что-то менять. Или старые сервера на новые или смотреть в сторону виртуализации.

VMWARE. Знакомство

Знакомство с vmware случилось впервые у меня на 3 курсе (2004) когда я пошел работать в местную контору TOMLINE (Zmodem, evg33 – спасибо Вам) именно там я в первый раз в жизни поставил vmware workstation для того чтобы побаловаться с linux и freebsd и ничего не поломать на работающих серверах. Тогда жутко не хватало ни процессора ни памяти – и выглядело очень уныло и не перспективно. Проводя аналогию могу сказать что приблизительно так же я познакомился с windows 3.11 когда в 5ом классе запускал его из Norton Commander`а смотрел на «окна» запускал в них paint, а потом закрывал и продолжал использовать в качество основной ОС – DOS, все мы знаем где сегодня DOS, а где Windows =). Однако время шло, на дворе был далекий 2009, начались конференции и вебинары посвященные виртуализации. Первые опыты внедренные в работу существующей сети я ставил на vmware Infrastructure – бесплатная софт от vmware, который ставится поверх windows в которой можно разворачивать виртуальные машины и она «умеет VLAN`ы». Дальше больше, большую роль сыграл бесплатный вебинар от Максима Мошкова (я до сих пор не могу понять lib.ru – его проект?). Впервые доступным языком рассказали, а главное показали, что такое HA, Failover, DRS и т.д. и вживую продемонстрировали, как оно работает и ответили на все мои вопросы (очень часто приходится посещать семинары, где менеджеры-продавцы много рассказывают по слайдам-заготовкам, когда же спросишь чуть в сторону – ответить ничего не могут, если это читают представители vmware: пожалуйста, выделяйте тех специалиста для таких презентаций).

VMWARE: Внедрение

Конец 2009 выдался довольно интересным. В результате вступления в должность нового мэра весь аппарат мэрии (большая его часть) перешел на мобильные устройства. Если раньше все что было нужно это ноутбук с интернетом и покупка wi-fi точек на каждый этаж полностью решала все проблемы и потребности, то с приходом нового руководства требования «немножко» подросли: электронный документооборот должен был работать на всех мобильных платформах: windows mobile (коммуникаторы), iOs (айфоны уже были и немного позже появится ipad), symbian (по прежнему есть любители NOKIA) — и все это должно работать и поддерживать корпоративную почту и разумеется «надо еще вчера». Именно тогда я в первый раз столкнулся с нехваткой серверов. Сервис нужен. Сервера нет. Зашли мы в серверную – подумать. Вижу контроллер домена – все как надо на отдельной железке, рядом сервер под оракл – собирает статистику посещения муниципального сайта. Ну и пришла в голову идея виртуализировать эти два сервера. И вот свежепоставленный esxi 4.0 зарегистрированный на сайте vmware стоит в нашей сети. Как известено одинокостоящий гипервизор после регистрации – бесплатен и это хороший маркетинговый ход. Так в администрации города Томска появился первый гипервизор на базе vmware.

Выбираем VMWARE

Если сегодня для меня выбор бренда для виртуализации очевиден, то в 2010 были очень большие дебаты: vmware, xen, hyper-v. Особо крупно эти дебаты развернулись, когда впервые стали возникать вопросы по приобретению площадки для виртуализации, а главное о выделении средств на эту площадку. Каким-то «магическим» образом об этом узнали крупные поставщики серверного железа из соседних городов и начали предлагать и продвигать свои решения. Тут стоит отметить настойчивость microsoft: они молодцы, в далеком сибирском городе про них рассказывали все чаще. Много кто рекламировал hyper-v, но при этом постоянно было слышно: вот-вот и мы догоним vmware – про vmware тоже было слышно многое, но в основном из вебинаров. А вот то, что касается XEN – то тут провал, очень мало информации (в то время). Я честно поставил hyper-v, но как оказалось в 2010 он плохо работал с freebsd, а именно эта операционная система использовалась на серверах находящихся в DMZ нашей сети, которую так же планировалось виртуализировать (при этом посещение семинара «облака без бла-бла-бла» от microsoft 11 апреля 2012 года так же показало небольшое отставание microsoft от своих коллег их vmware, семинар начался со слов: «Ну вот мы и догнали vsphere 5.0 в своем новом windows server 8» дальше идут цифры-цифры-цифры, но оказывается что релиз будет то ли в октябре, то ли в ноябре, а грузится с хранилища оно так и не умеет – если честно, я не понимаю, почему? Я может субъективно смотрю на вещи, но когда вы покупаете хранилище, которое как правило дороже любого сервера и у вас разумеется есть для неё поддержка и запасные винчестеры, зачем использовать локальные винчестеры на хостах? Для чего? Непонятно. Так же были попытки изучать KVM, но отсутствие клиента под windows было первым неудобством, которое сразу не понравилось. Итак – VMWARE: все бы хорошо, но вот цена… При самых скромных подсчетах лицензия получалась в районе 500 000, но в ней не было бы никакого смысла, если нет хранилища и двух идентичных серверов-хостов для организации отказоустойчивого кластера.

Внедряем по чуть-чуть

Так сложились мои должностные обязанности, что в первую очередь я должен был отвечать за работоспособность леса доменов в Active Directory. Когда я пришел на работу то обнаружил порядка 8 «забытых» контроллеров и 2 «не нужных» домена. И если в головном домене (если так можно сказать) все вроде было хорошо, то ошибки в журнал службы каталогов сыпались ежедневно. После исследования причин возникновения некорректно удаленных контроллеров домена, стало ясно: проблемы начинаются, когда на контроллер домена вещают задачи, которые он не должен выполнять. Логично разнести контроллер домена, резервный контроллер, файловый сервера, антивирус и т.д. по разным серверам, но как это сделать, если имеется всего один физический сервер? Вот тут на помощь и приходит vmware со своим гипервизором esxi: на одном физическом сервере мы запускаем столько операционных систем сколько нужно, однако по прежнему зависим от «железа». Если случится что-нибудь с рейд массивом, памятью, материнской платой, то возникнет определенное время простоя и так как контроллер домена будет не доступен, возникнут определенные сложности. Возник вопрос о создании выделенного сервера под резервные контроллеры на базе esxi.

Так устроено большинство корпоративных сетей (сеть администрации города Томска – не исключение), что каждое подразделения приходит по своей оптике и живет в своей подсети (в своем VLAN`е). Если в головной структуре организовать сервер на esxi с виртуальными машинами и прокинуть туда существующие VLAN`ы, то будет возможность создать по резервному контроллеру домена, о котором некоторые «местные» администраторы даже не узнают, которые будут находится в тех же подсетях что и основные контроллеры. В этом случае, если что-то случается с основным контроллером (как показывает практика то стабильно раз в месяц в одном домене да случается), то пользователи авторизуются на втором, всегда есть возможность развернуть ДХЦП, ну а если совсем все плохо с основным (сгорела материнская плата – такое у нас было), захватываем роли и вычищаем ntdsutil`ом данные о старом сервере. В любом случае, это проще чем создавать новый домен с нуля и ходит добавлять компьютеры в новый домен и т.д. (и такое у нас было). Собственно развернуть отдельный esxi хост и поднять на нем такие «резервные контроллеры» получилось довольно быстро. Он стабильно работает уже год и все к нему привыкли.

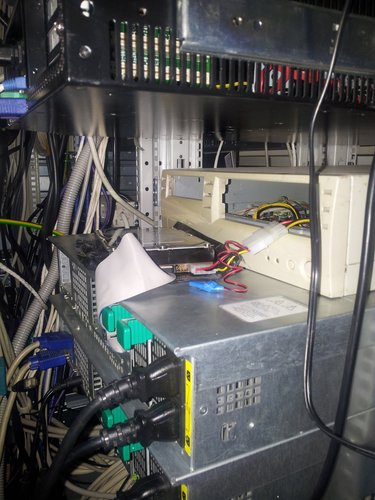

Отдельно стоящий хост – это замечательно. Но хотелось увидеть все прелести High-Availability. И если сферу (vmware vsphere) можно было использовать в течение 60 дней, то где взять хранилище? Тут на помощь приходит freenas и iscsi. В принципе хорошее решение, но добиться от него стабильности и высокой производительности так и не получилось. Не буду вдаваться в подробности, статья не про это. Проблемы начались в ноябре 2011. На каждых выходных (делаются бекапы, повышается дисковая активность), начали «некорректно» работать рейд-массивы: то винчестер в оффлайн уйдет, то загружается только с 3 раза. Проблемным был один из винчестеров, но пока его вычислили, нервов попортили не мало. А когда это происходит на главном файловом сервере, то это особенно грустно. А тут еще и «кризис места»: нужно бекапить 500 Гб, а некуда. Вот и приходится подключать к серверу внешний IDE винчестер, но из-за отсутствия IDE-шного питания пришлось держать его с открытой крышкой и запитать от обычного компьютера. Что дало перегрев винчестеров, которые не охватывались вентиляторами. Пришлось вынимать пластину закрывающую слот расширения, и протянуть IDE шлейф через образовавшееся окошко. Крышку закрыли, IDE винчестер сверху, температура винчестеров в сервере упала, глюки прекратились. И все это в ожидании нормального хранилища.

Летом 2011 года: в рамках целевой программы появляется возможность обновить серверное оборудование. Провели два аукциона и приобрели один мощный сервер и хранилище. И заложили в бюджет 2012, что в январе будет еще один аукцион на второй такой сервер, а во втором квартале покупаем, снова через аукцион программное обеспечение для виртуализации. Кстати благодаря аукциону сэкономили 9,5% от начальной цены. В результате всё успешно получено и запущено в марте 2012.

Железо

В итоге мы получили:

Сервера

Платформа Intel 1U SR1695WBA (LGA1366, i5500, PCI-E, SVGA, SATA RAID,4xHotSwapSAS/SATA, 2xGbLAN, 8DDR-III, 2*450W); Intel Xeon X5675; 64 GB RAM – 2 шт

Контроллеры:

LSI Logic Host Bus адаптер SAS 9205-8e SGL (LSI00285) – 2 шт

Qlogic iSCSI Dual Prt PCIe HBA – 3шт

Система хранения данных

LSI Server ACC DRIVE CHASSIS/CDE 2600-12 со встроенным iSCSI и Raid контроллером LSI SERVER ACC Raid ISCSI SAS CRU/2600 2 Gb M102248 — 1 шт

SERVER ACC HDD 2TB 7.2k SAS/44354-00 M102349 PACL LSI – 12шт

Идея: все высоконагруженные сервера перенести на отказустойчивый кластер состоящий из двух хостов (два новых сервера) которые будут подключены к хранилищу по SAS освободившееся сервера (поновее, у которых есть PCIe слот) подключить к хранилищу по iscsi (еще 4 сервера). Как видно на оптику денег не хватило, а SAS вроде как должен устраивать. При этом LSI заявил о выходе SAS HBA свитча, который позволит подключить еще больше серверов к хранилищу по SAS.

Из 3 заказанных iscsi плат полностью рабочей оказалась только одна!!! Одна стразу не увидела хранилище, вторая как выяснилось позже, не дает грузиться с хранилища.

HBA SAS пришли на месяц позже. Они заработали без каких-либо проблем. На данный момент пока три хоста грузятся с хранилища. Ждем пока заменят по гарантии QLogic-и

Выводы

В результате внедрения VMWARE vSphere 5.0 в корпоративной сети муниципалитета г. Томска можно сделать следующие выводы:

1. Повышена отказоустойчивость работы критически важных серверов за счет создания High-Availabilty кластера.

2. Возможность живой миграции позволяет проводить регламентные работы без прекращения работы критических серверов.

3. Сокращение потребления электропитания с 5,3 кВт/ч до 3,8 кВт/ч (экономия 60 000 рублей в год).

4. Удобство администрирования: единая консоль управления, нет «привязки» к железу.

В общем если у вас 3 и более отдельно стоящих серверов, то виртуализировать несомненно стоит.

VMWARE: PSOD к нам приходит

Все настроено и работает. В результате миграции выключили 6 старых серверов. В планах еще 5. Удобство миграции виртуалок, которых уже 34 не может не радовать. Вообще виртуализации сильно расслабляет – но безусловно упрощает жизнь администратора. И пришел вторник 24 апреля 2012. Как обычно прихожу на работу и вижу аларм от Nagios, что один из хостов не доступен. Монитор же показал мне вот такую картину:

Немножко гугла и все в принципе ясно communities.vmware.com/thread/311457?start=0&tstart=0 (вообще база знаний vmware радует, чего не скажешь про их download center). Но у нас же обязательная поддержка. По условиям Vmware поддержка осуществляется только после регистрации продукта: ок, регистрируемся. Получаем еще один интересный скриншот.

Связываемся с поставщиками, нам рекомендуют отписать на почту: vi-hotline@vmware.com

Пишем письмо. Получаем ответ.

Thank you for requesting support from VMware Licensing Support. Your Support Request Number is 12167833904

A Licensing Support Specialist will respond to your query within 12 hours.

Сейчас 12 часов прошло, но ответа не последовало. А жаль. Ну вот в принципе и все. Сейчас утро 25 апреля. И этот скромный очерк об опыте внедрения VMWARE vSphere 5.0 на примере муниципалитета г.Томска подошел к концу. Если у Вас есть вопросы, предложения, желание обменяться опытом – пишите gtt@admin.tomsk.ru постараюсь ответить всем. Спасибо, что прочли эту статью до конца.