В предыдущей статье я рассказал о «не-FlexPod DC» архитектуре, которая может поддерживаться из «одних рук» по программе Cisco «Solution Support for Critical Infrastructure» (SSCI). Основная её особенность состоит в том, что в ней нет коммутаторов серии Nexus, а если их туда добавить, такая архитектура может стать полноценным FlexPod DataCenter.

Здесь пойдёт речь про новый дизайн сети, для FlexPod DataCenter, с прямым включением СХД NetApp в UCS домен. Отличие от стандартной архитектуры FlexPod DataCenter заключается в том, что коммутаторы Nexus расположены не между UCS и NetApp, а «поверх» UCS.

Несмотря на то, что и раньше СХД NetApp серии FAS можно было подключить напрямую к Fabric Interconnect (FI), официально архитектура FlexPod DataCenter не предусмаривала такого дизайна. Теперь дизайн с прямым включением поддерживается и сапортиться, как FlexPod DataCenter архитектура.

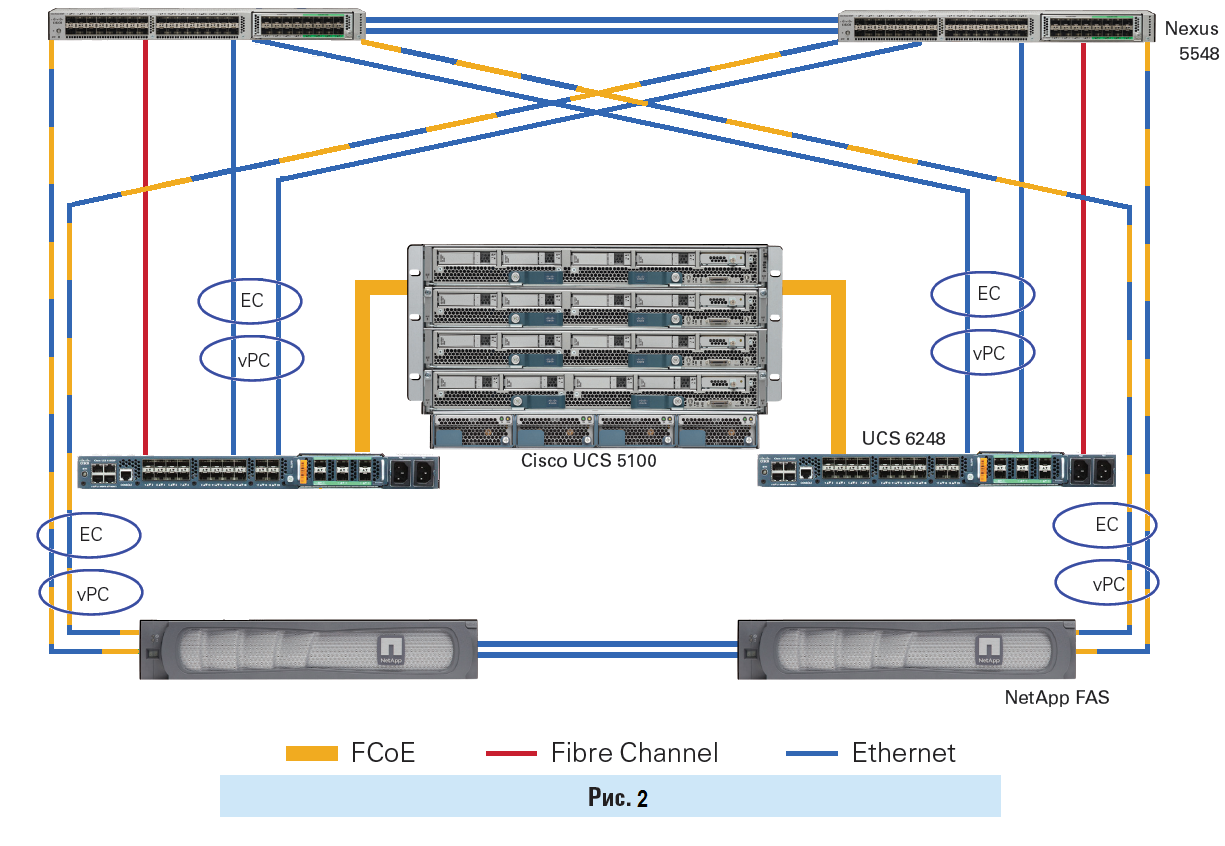

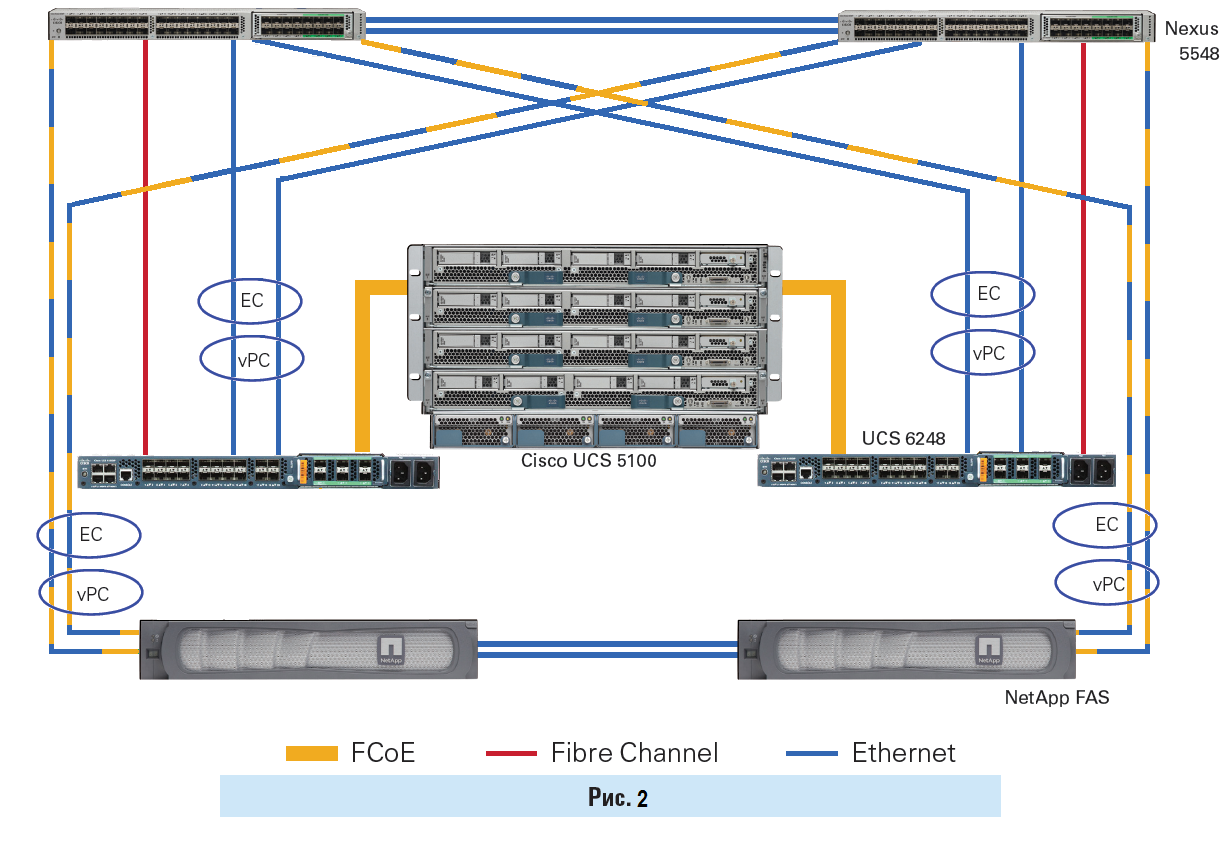

Общий дизайн сети FC и FCoE с прямым включением.

Для Ethernet трафика совместно как с прямым включением и протоколом iSCSI, так и прямым включением и протоколом FCP — при помощи мультипасинга встроенного в эти протоколы, нет проблем в настройке отказоустойчивости и балансировке по линкам.

А вот для NAS протоколов, с прямым включением (NFS v2/NFS v3 и CIFS v1/CIFS v2), в виду отсутствия балансировки нагрузки и мультипасинга внутри этих протоколов, их функцию должны выполнять какие-то другие, нижелижащие протоколы, такие как LACP и vPC (FI не поддерживает vPC), таким образом отказоустойчивость для Ethernet сети прийдётся строить как-то по-другому. К примеру отказоустойчивость для Ethernet можно сделать на уровне виртуального свича (что может иметь проблемы с производительностью такого коммутатора) или при помощи active-passive переключения агрегированного сетевого линка, без LACP (что не позволит балансировать трафик по всем доступным линкам), для этого агрегированный линк ifgrp, со стороны СХД, должен быть настроен в режим single-mode.

Вопрос с прямым включением для NAS протоколов не так остро смотрится для NFS v4 и CIFS v3.0, но требует поддержку этих протоколов на стороне клиентов и СХД (все системы FAS с cDOT поддерживают NFS v4 и CIFS v3.0), так как оба протокола наконец-то преобрели некое подобие мультипасинга.

Дело в том, что NetApp в своих новых решениях часто придерживается идеологии «лучше перебдеть, чем недобдеть». Так, когда вышла в мир ОС Clustered ONTAP для СХД FAS, обязательно для кластерного интерконнека было наличие выделенных коммутаторов Nexus 5k (за 1$) исключительно под эту задачу. Со временем такая конфигурация была пересмотрена, протестирована и добавлена возможность switch-less конфигураций. Точно так же понадобилось время для тестирования и отладки прямого включение СХД, сначала добавили новые топологии Cisco UCS Manager based FC zoning с прямым включением (direct connect topologies) СХД в UCS домен, это стало доступно с версией прошивки Release 2.1(1a), а потом это появилось в FlexPod архитектуре.

Конфигурация с прямым включением СХД в FI, с точки зрения архитектурных отличий, в случае использования блочных протоколов длоступа FC/FCoE/iSCSI, наименьшим образом отличается от первоначального дизайна FlexPod, где Nexus коммутаторы играли роль связующего звена между хранилищем и UCS доменом. Тем не мение в новом дизайне коммутаторы серии Nexus по-прежднему являются обязательным компонентом архитектуры:

Отличие дизайнов SAN и NAS заключается в том, что в случае блочных протоколов механизмы мультипасинга и балансировки выполняются на уровне протоколов FC/FCoE/iSCSI, а в случае использования NFS/CIFS (SMB) протоколов эти механизмы отсутствуют. Функции мультипасинга и балансировки необходимо выполнять на уровне Ethernet при помощи vPC и LACP, т.е. средствами коммутатора, что и я вляется определяющим фактором его наличия в таких дизайнах.

Не смотря на то, что коммутаторы Nexus являются обязательным компонентом архитектуры FlexPod DataCenter, прямое подключение снижает стоимость такого решения на первом этапе ввода в эксплуатацию комплекса, т.е. позволит не покупать коммутаторы Nexus вначале. Другими словами можно сначала собрать non-FlexPod DC. А потом докупить коммутаторы спустя время, размазав затраты по бюджету более тонким слоем и получив более масштабируемую архитектуру FlexPod DataCenter, когда в этом будет необходимость.

В последующем дизайн сети может быть преобразован в более масштабируемый, а благодаря дублированию компонент это можно выполнить без останова комплекса.

Ограничением дизайна сети представленного на Рис.2 является 2 линка от одного контроллера СХД к коммутаторам, когда по ним ходит одновременно FCoE и Ethernet трафик. Если понадобится увеличить число линков от СХД прийдётся разделить FCP и Ethernet трафик по отдельным, выделенным портам и линкам.

Преимущества FlexPod конфигураций.

Вышли новые документы по внедрению архитектуры ЦОД: FlexPod Express, Select и DataCenter с Clustered Data ONTAP (cDOT):

Сообщения по ошибкам в тексте прошу направлять в ЛС.

Замечания и дополнения напротив прошу в комментарии

Здесь пойдёт речь про новый дизайн сети, для FlexPod DataCenter, с прямым включением СХД NetApp в UCS домен. Отличие от стандартной архитектуры FlexPod DataCenter заключается в том, что коммутаторы Nexus расположены не между UCS и NetApp, а «поверх» UCS.

Несмотря на то, что и раньше СХД NetApp серии FAS можно было подключить напрямую к Fabric Interconnect (FI), официально архитектура FlexPod DataCenter не предусмаривала такого дизайна. Теперь дизайн с прямым включением поддерживается и сапортиться, как FlexPod DataCenter архитектура.

Общий дизайн сети FC и FCoE с прямым включением.

Описние схемы коммутации на изображении выше

Одновременное подключение по FC и FCoE изображено по двум причинам:

Ethernet соединение между двумя контроллерами NetApp FAS изображены по двум причинам:

FC линк от FI до Nexus коммутатора изображен по двум причинам:

- Так действительно можно сделать и это будет работать

- Чтобы показать что можно FC и/или FCoE.

Ethernet соединение между двумя контроллерами NetApp FAS изображены по двум причинам:

- Чтобы показать, что это две ноды одной НА системы (если нод больше, на картинке обязательно были бы кластерные свичи).

- Внешний кластерный линк обязательный аксесуар операционной системы Clustered DataONTAP.

FC линк от FI до Nexus коммутатора изображен по двум причинам:

- Для будущего. Когда нам понадобится переключить NetApp на Nexus коммутаторы и FI получали доступ к своим LUN'ам. После чего схема станет более масштабируема, можно будет добавлять ещё UCS домены.

- Для того, чтобы забирать ресурсы с хранилища с других серверов, которые не входят в UCS домен. К примеру UCS Rack серверов (UCS C серия) не подключённых к FI или серверов других производителей.

Для Ethernet трафика совместно как с прямым включением и протоколом iSCSI, так и прямым включением и протоколом FCP — при помощи мультипасинга встроенного в эти протоколы, нет проблем в настройке отказоустойчивости и балансировке по линкам.

А вот для NAS протоколов, с прямым включением (NFS v2/NFS v3 и CIFS v1/CIFS v2), в виду отсутствия балансировки нагрузки и мультипасинга внутри этих протоколов, их функцию должны выполнять какие-то другие, нижелижащие протоколы, такие как LACP и vPC (FI не поддерживает vPC), таким образом отказоустойчивость для Ethernet сети прийдётся строить как-то по-другому. К примеру отказоустойчивость для Ethernet можно сделать на уровне виртуального свича (что может иметь проблемы с производительностью такого коммутатора) или при помощи active-passive переключения агрегированного сетевого линка, без LACP (что не позволит балансировать трафик по всем доступным линкам), для этого агрегированный линк ifgrp, со стороны СХД, должен быть настроен в режим single-mode.

Вопрос с прямым включением для NAS протоколов не так остро смотрится для NFS v4 и CIFS v3.0, но требует поддержку этих протоколов на стороне клиентов и СХД (все системы FAS с cDOT поддерживают NFS v4 и CIFS v3.0), так как оба протокола наконец-то преобрели некое подобие мультипасинга.

настроить FCoE и CIFS/NFS трафик поверх одного линка

Далее идём по настройкам:

Со стороны хранилища NetApp нужно перевести порты в состояние CNA (нужно наличие CNA портов, обычные Ethernet 1/10Gbs порты этого не поддерживают), при помощи команды ucadmin на СХД (потребуется перезапуск СХД). В системе будут отображаться независимо «виртуальные» порты Ethernet и «виртуальные» FC порты, раздельно (хотя физический порт для одного такого «виртуального» Ethernet и одного «виртуального» FC будет использован один). Настраиваются такие порты отдельно, как обычные физические порты.

На FI нужно включить FC режим в состояние «Switching mode», в настройках Fabric A/B на вкладке «Equipment». Эта настройка потребует перезапуска FI.

Если вы хотите перевести некоторые порты в режим FC, то в настройках Fabric A/B на вкладке «Equipment» выберите «Configure Unified Ports» и в мастере выберите необходимое количество FC портов (они выбираются справа). FI снова перезагрузиться.

После перезагрузки FI на вкладке «Equipment» необходимо конвергентные или FC порты будет перевести в режим «Appliance port», после нескольких секунд порт перейдёт в режим онлайн. Потом перенастройте порт в режим «FCoE Storage Port» или в режим «FC Storage Port», на правой панели вы увидите тип порта "Unified Storage". Теперь будет возможночть выбрать VSAN и VLAN для такого порта. И важный момент, созданный ранее VSAN, должен иметь включенный “FC zoning” на FI чтобы выполнять зонинг.

Настройка зонинга на FI:

SAN->Storage Cloud->Fabric X->VSANs->Create «NetApp-VSAN-600»->

VSAN ID: 600

FCoE VLAN ID: 3402

FC Zonning Settings: FC Zonning -> Enabled

SAN->Policies->vHBA Templates->Create «vHBA-T1»->VSAN «NetApp-VSAN-600»

SAN->Policies->Storage Connection Policies->Create «My-NetApp-Conn»->Zoning Type->Sist (или Simt если нужно) -> Create->

FC Target Endpoint: «NetApp LIF's WWPN» (начинается с 20:)

SAN->Policies->SAN Connectivity Policies->Create «NetApp-Conn-Pol1»->vHBA Initiator Group->

Create «iGroup1»->Select vHBA Initiators «vHBA-T1»

Select Storage Connectivity Policy: «My-NetApp-Conn»

При создании Server Profile исспользовать созданные политики и vHBA тимплейт.

- Во-первых, нужна версия прошивки Cisco UCS firmware 2.1 или выше

- Во-вторых, нужно хранилище с 10GB CNA/UTA портами

Далее идём по настройкам:

Со стороны хранилища NetApp нужно перевести порты в состояние CNA (нужно наличие CNA портов, обычные Ethernet 1/10Gbs порты этого не поддерживают), при помощи команды ucadmin на СХД (потребуется перезапуск СХД). В системе будут отображаться независимо «виртуальные» порты Ethernet и «виртуальные» FC порты, раздельно (хотя физический порт для одного такого «виртуального» Ethernet и одного «виртуального» FC будет использован один). Настраиваются такие порты отдельно, как обычные физические порты.

На FI нужно включить FC режим в состояние «Switching mode», в настройках Fabric A/B на вкладке «Equipment». Эта настройка потребует перезапуска FI.

Если вы хотите перевести некоторые порты в режим FC, то в настройках Fabric A/B на вкладке «Equipment» выберите «Configure Unified Ports» и в мастере выберите необходимое количество FC портов (они выбираются справа). FI снова перезагрузиться.

После перезагрузки FI на вкладке «Equipment» необходимо конвергентные или FC порты будет перевести в режим «Appliance port», после нескольких секунд порт перейдёт в режим онлайн. Потом перенастройте порт в режим «FCoE Storage Port» или в режим «FC Storage Port», на правой панели вы увидите тип порта "Unified Storage". Теперь будет возможночть выбрать VSAN и VLAN для такого порта. И важный момент, созданный ранее VSAN, должен иметь включенный “FC zoning” на FI чтобы выполнять зонинг.

Настройка зонинга на FI:

SAN->Storage Cloud->Fabric X->VSANs->Create «NetApp-VSAN-600»->

VSAN ID: 600

FCoE VLAN ID: 3402

FC Zonning Settings: FC Zonning -> Enabled

SAN->Policies->vHBA Templates->Create «vHBA-T1»->VSAN «NetApp-VSAN-600»

SAN->Policies->Storage Connection Policies->Create «My-NetApp-Conn»->Zoning Type->Sist (или Simt если нужно) -> Create->

FC Target Endpoint: «NetApp LIF's WWPN» (начинается с 20:)

SAN->Policies->SAN Connectivity Policies->Create «NetApp-Conn-Pol1»->vHBA Initiator Group->

Create «iGroup1»->Select vHBA Initiators «vHBA-T1»

Select Storage Connectivity Policy: «My-NetApp-Conn»

При создании Server Profile исспользовать созданные политики и vHBA тимплейт.

Почему прямого включения не было раньше в FlexPod DataCenter?

Дело в том, что NetApp в своих новых решениях часто придерживается идеологии «лучше перебдеть, чем недобдеть». Так, когда вышла в мир ОС Clustered ONTAP для СХД FAS, обязательно для кластерного интерконнека было наличие выделенных коммутаторов Nexus 5k (за 1$) исключительно под эту задачу. Со временем такая конфигурация была пересмотрена, протестирована и добавлена возможность switch-less конфигураций. Точно так же понадобилось время для тестирования и отладки прямого включение СХД, сначала добавили новые топологии Cisco UCS Manager based FC zoning с прямым включением (direct connect topologies) СХД в UCS домен, это стало доступно с версией прошивки Release 2.1(1a), а потом это появилось в FlexPod архитектуре.

Зачем нужны Nexus свичи?

Конфигурация с прямым включением СХД в FI, с точки зрения архитектурных отличий, в случае использования блочных протоколов длоступа FC/FCoE/iSCSI, наименьшим образом отличается от первоначального дизайна FlexPod, где Nexus коммутаторы играли роль связующего звена между хранилищем и UCS доменом. Тем не мение в новом дизайне коммутаторы серии Nexus по-прежднему являются обязательным компонентом архитектуры:

- во-первых, потому, что FlexPod должен быть каким-то образом интегрирован в существующую инфраструктуру и предоставлять доступ клиентам

- во-вторых, прямое включение будет сдерживать масштабируемость архитектуры в будущем

- в третьих, в отличие от прямого включения c SAN (FC/FCoE/iSCSI), дизайн Ethernet сети для NAS требует наличия промежуточного связующего звена между СХД и UCS домена для выполнения балансировки нагрузки по сетевым линкам, и главным образом, функций отказоустойчивости.

- в-четвертых доступ внешних клиентов по Ethernet к FlexPod должен быть отказоустойчивым.

Наличие коммутаторов для NAS

Отличие дизайнов SAN и NAS заключается в том, что в случае блочных протоколов механизмы мультипасинга и балансировки выполняются на уровне протоколов FC/FCoE/iSCSI, а в случае использования NFS/CIFS (SMB) протоколов эти механизмы отсутствуют. Функции мультипасинга и балансировки необходимо выполнять на уровне Ethernet при помощи vPC и LACP, т.е. средствами коммутатора, что и я вляется определяющим фактором его наличия в таких дизайнах.

Как уменьшить затраы на первом этапе

Не смотря на то, что коммутаторы Nexus являются обязательным компонентом архитектуры FlexPod DataCenter, прямое подключение снижает стоимость такого решения на первом этапе ввода в эксплуатацию комплекса, т.е. позволит не покупать коммутаторы Nexus вначале. Другими словами можно сначала собрать non-FlexPod DC. А потом докупить коммутаторы спустя время, размазав затраты по бюджету более тонким слоем и получив более масштабируемую архитектуру FlexPod DataCenter, когда в этом будет необходимость.

В последующем дизайн сети может быть преобразован в более масштабируемый, а благодаря дублированию компонент это можно выполнить без останова комплекса.

Ограничением дизайна сети представленного на Рис.2 является 2 линка от одного контроллера СХД к коммутаторам, когда по ним ходит одновременно FCoE и Ethernet трафик. Если понадобится увеличить число линков от СХД прийдётся разделить FCP и Ethernet трафик по отдельным, выделенным портам и линкам.

Преимущества FlexPod конфигураций.

Новинки конфигураций и дизайнов

Вышли новые документы по внедрению архитектуры ЦОД: FlexPod Express, Select и DataCenter с Clustered Data ONTAP (cDOT):

- Nexus 6000/9000: FlexPod Datacenter with VMware vSphere 5.1U1 and Cisco Nexus 6000 Series Switch Design Guide, FlexPod Datacenter with VMware vSphere 5.5 and Cisco Nexus 9000 Series Switches

- MetroCluster on cDOT (MCC): MetroCluster in Clustered Data ONTAP 8.3 Verification Tests Using Oracle Workloads

- All-Flash FAS (AFF): FlexPod Datacenter with NetApp All-Flash FAS and VMware Horizon (with View), FlexPod Datacenter with VMware vSphere 5.5 Update 1 and All-Flash FAS.

- FlexPod Express: FlexPod Express with VMware vSphere 5.5: Large Configuration, FlexPod Express with VMware vSphere 5.5 Update 1: Small and Medium configs Implementation Guide.

- Cisco Security: FlexPod Datacenter with Cisco Secure Enclaves

- Cisco ACI: FlexPod Data Center with Microsoft SharePoint 2013 and Cisco Application Centric Infrastructure (ACI) Design Guide, FlexPod Datacenter with VMware vSphere 5.1 U1 and Cisco ACI Design Guide, FlexPod и Cisco ACI — идеальное сочетание

- FlexPod Select: FlexPod Select for High-Performance Oracle RAC NVA Design

- FlexPod + Veeam Install Guide: How Veeam provides availability for Cisco and NetApp converged infrastructures

Сообщения по ошибкам в тексте прошу направлять в ЛС.

Замечания и дополнения напротив прошу в комментарии