Google, Facebook и Amazon не продают коммутаторы и никогда не будут этим заниматься. Однако этим компаниям удалось изменить то, как такое оборудование продают другие.

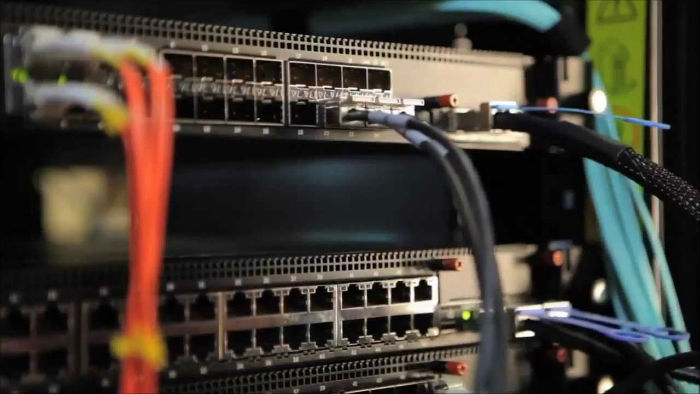

Без коммутаторов («свитчей») невозможно представить себе работу интернета — ведь именно с их помощью огромные объемы данных пересылаются между дата-центрами и частными сетями. Традиционно, на рынке продажи этих устройств доминировали большие американские компании вроде Cisco и Juniper — они предлагают покупателям довольно дорогое оборудование, работающее на проприетарном софте.

Но традиционное устройство этого рынка постепенно стало все более неудобным для растущих Google, Facebook и Amazon. Оборудование американских компаний было слишком дорогим и сложным в настройке, поэтому интернет-гиганты обратили свой взор на продавцов «железа» из Азии.

Прежде всего, им удалось договориться об установке на оборудование азиатских производителей «кастомных» прошивок. Сначала производители неохотно соглашались на подобную практику (и позднее некоторые от нее отказались вовсе, поскольку создавать свой подобный софт могут только ИТ-гиганты). Однако позднее рынок потянулся в эту сторону.

На прошлой неделе HP объявила о том, что начнет продавать «только железные» (то есть без софта) коммутаторы, на которые любой желающий сможет установить своей собственное программное обеспечение. На первый взгляд, не слишком впечатляющая новость, однако она говорит об огромном сдвиге всей парадигмы рынка сетевых устройств. В деле предоставления покупателям «голого» железа HP идет вслед за Juniper и Dell.

«Все происходит куда быстрее, чем я представлял», — говорит Джей Ар Риверс (JR Rivers), CEO Cumulus Networks, стартапа, который создает программное обеспечение для коммутаторов — этот софт HP также собирается предлагать своим клиентам.

Джей Ар Риверс

Некоторе время Риверс работал над созданием сетевого оборудования в Google, а теперь продвигает те же самые идеи на всем рынке в целом. Google создавал свитчи, на которое можно установить собственное сетевое ПО и в дальнейшем обновлять его, теперь Cumulus помогает другим компаниям делать то же самое.

Пару недель назад соцсеть Facebook объявила о переводе своих дата-центров на разработанные внутри компании коммутаторы и софт для управления ими.

Модульный коммутатор Facebook под названием «6-pack»

Складывающейся ситуацией явно обеспокоены в Cisco, считают журналисты Wired, ведь сразу после новости от Facebook, производитель сетевого оборудования прислал в издание пресс-релиз, в котором утверждалось, что «8 из 10 самых крупных интернет-компаний являются клиентами Cisco», а Facebook создает собственные сервера потому что «компания может удовлетворить некоторые уникальные требования только с помощью собственных разработок».

На самом же деле ничего уникального в идее перехода на собственное оборудование нет.

Кейд Метц из Wired считает, что в скором времени рынок сетевого оборудования станет похож на рынок PC и серверов — «железо» и «софт» будут разделены, что позволит клиентам комбинировать их, затачивая под собственные нужды.