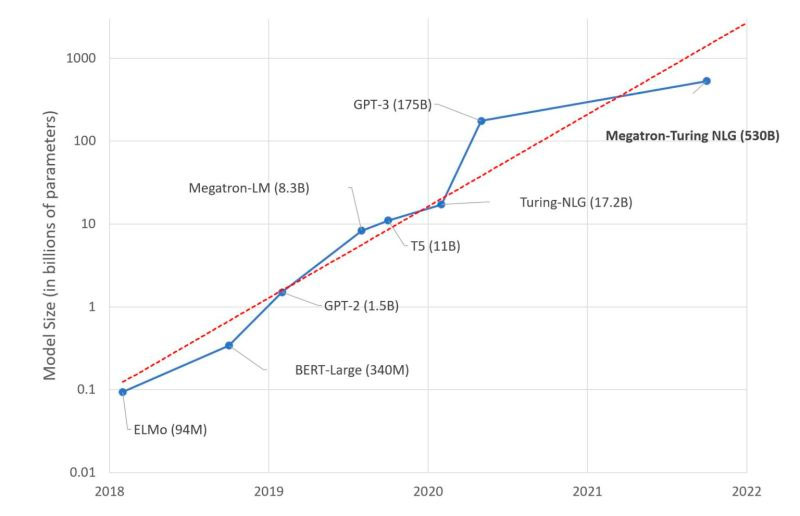

Microsoft и NVIDIA объединились для создания Megatron-Turing Natural Language Generation ― генеративной языковой ИИ-модели с 530 млрд параметров. Это крупнейшая в мире монолитная трансформаторная языковая модель.

MT-NLG обладает в три раза большим количеством параметров по сравнению с предыдущей крупнейшей ИИ-системой GPT-3 (175 млрд). В число функций MT-NLG входят:

Предсказание текста по смыслу;

Понимание прочитанного;

Генерация логических выводов;

Создание заключений на естественном языке;

Различение смысла слов с несколькими значениями.

Систему MT-NLG обучали с помощью суперкомпьютера NVIDIA Selene, который состоит из 560 серверов DGX A100. Каждое устройство оснащено восемью графическими 80 ГБ процессорами A100. По данным The Next Platform, стоимость NVIDIA Selene доходит до 85 млн долларов.

Для обучения MT-NLG Microsoft и NVIDIA использовали мощности библиотеки DeepSpeed, работающую на коде PyTorch, ― благодаря ей разработчики смогли загружать в MT-NLG огромные потоки данных одновременно.

По словам представителей Microsoft, процесс обучения ИИ-системы занял чуть больше месяца, в течение которого специалисты обработали более 1,5 ТБ данных. В процессе обучения разработчики использовали 11 больших баз данных, в их число входят Wikipedia, PudMed, массивы художественной литературы и многие другие.

Важно отметить, что в ИИ-системе нет фильтров, блокирующих токсичные и оскорбительные высказывания. Это значит, что качество текста, генерируемого нейросетью, очень зависит от использованных для обучения массивов данных.