Любой программист создающий нагруженные проекты с тысячами пользователей, когда-либо задавался вопросом, как он может улучшить SQL запросы и экономить многие сотни долларов. Процесс анализа обычно начинается с профилирования и отладки кода приложения. Далее происходит процесс оптимизации SQL запросов, для этого можно воспользоваться встроенными иструментами MySQL сервера. Например логирование MySQL в файл. Но рано или поздно начинаешь понимать, что это не удобно.

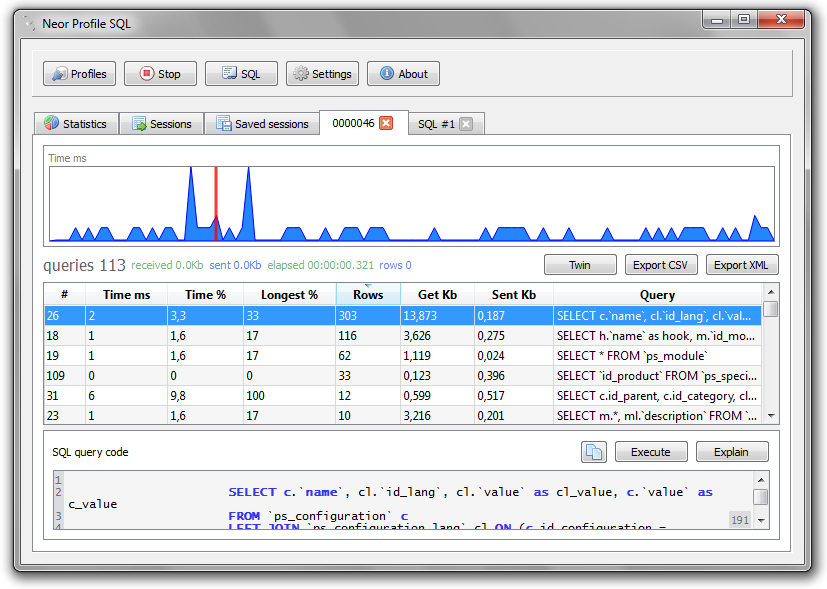

В специальном бесплатным профайлере Neor Profile SQL операции по оптимизации представляют собой простой процесс по настройке вашего приложения и сбора SQL запросов от него. Инструмент работает на всех широко используемых системах (Windows, Mac OS X и Linux). Поддерживает MySQL и MariaDB.

Neor Profile SQL работает как своего рода прокси и, следовательно, вам нужен компьютер, где вы можете открыть порты или в сети, в зависимости от требований. От вашего приложения требуется всего лишь изменить стандартный порт MySQL 3306 на установленный, обычно 4040. Остальное не требует пояснений, интерфейс прост в использовании.

В дополнение следует добавить основной функционал продукта:

— Подсчет всех запросов с детализацией по времени, коду и размеру

— Общая статистика строк полученных и отосланных в СУБД

— Поиск медленных запросов

— Сохранение сессии для последующего сравнения результатов

— Встроенная команда Explain любого запроса

— Программа бесплатная

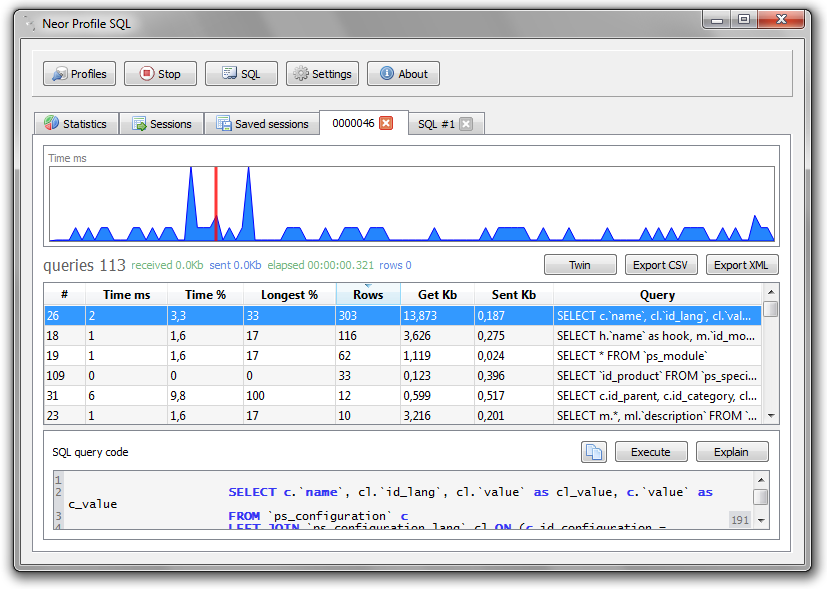

В специальном бесплатным профайлере Neor Profile SQL операции по оптимизации представляют собой простой процесс по настройке вашего приложения и сбора SQL запросов от него. Инструмент работает на всех широко используемых системах (Windows, Mac OS X и Linux). Поддерживает MySQL и MariaDB.

Neor Profile SQL работает как своего рода прокси и, следовательно, вам нужен компьютер, где вы можете открыть порты или в сети, в зависимости от требований. От вашего приложения требуется всего лишь изменить стандартный порт MySQL 3306 на установленный, обычно 4040. Остальное не требует пояснений, интерфейс прост в использовании.

В дополнение следует добавить основной функционал продукта:

— Подсчет всех запросов с детализацией по времени, коду и размеру

— Общая статистика строк полученных и отосланных в СУБД

— Поиск медленных запросов

— Сохранение сессии для последующего сравнения результатов

— Встроенная команда Explain любого запроса

— Программа бесплатная