Здравствуйте коллеги и жители Хабра. Хотим рассказать Вам историю одной небольшой компании от начала её становления до текущих реалий. Хотим сразу сказать, что данный материал сделан для людей, которым интересна эта тематика. Прежде чем это написать (и задолго до этого) мы пересмотрели множество публикаций на Хабре о строительстве ЦОДов и это очень помогло нам в реализации наших идей. Публикация будет разделена на несколько этапов нашей работы, от аренды шкафа до финала постройки собственного мини-цода. Надеюсь и эта статья поможет хотя бы одному человеку. Поехали!

В 2015 году, в Украине была создана хостинг-компания с большими амбициями на будущее и фактическим отсутствием стартового капитала. Оборудование мы арендовали в Москве, у одного из известных провайдеров (и по знакомству), это и дало нам начало развития. Благодаря нашему опыту и отчасти везению, уже в первые месяцы мы набрали достаточно клиентов, чтобы купить собственное оборудование и обзавестись хорошими связями.

Мы долго выбирали оборудование, которое нам нужно для собственных целей, выбирали сначала по параметрам цена/качество, но к сожалению большинство известных брендов (hp, dell, supermicro, ibm) все очень неплохи по качеству и схожи по цене.

Тогда мы пошли другим путем, выбирали из того что есть в Украине в наличии в больших количествах (на случай поломок или замены) и выбрали HP. Супермикро (как нам казалось) очень неплохо конфигурируются, но к сожалению их цена в Украине превышала всякий адекватный смысл. Да и запчастей было не так много. Так мы и выбрали, то что выбрали.

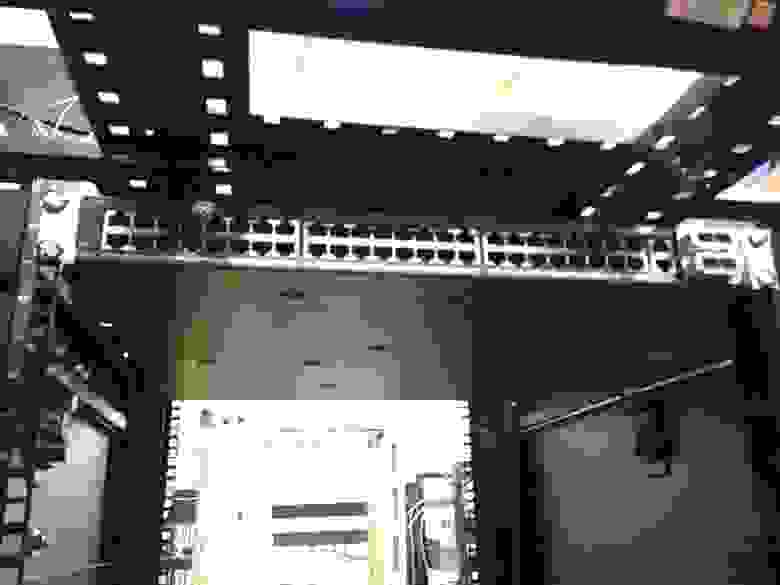

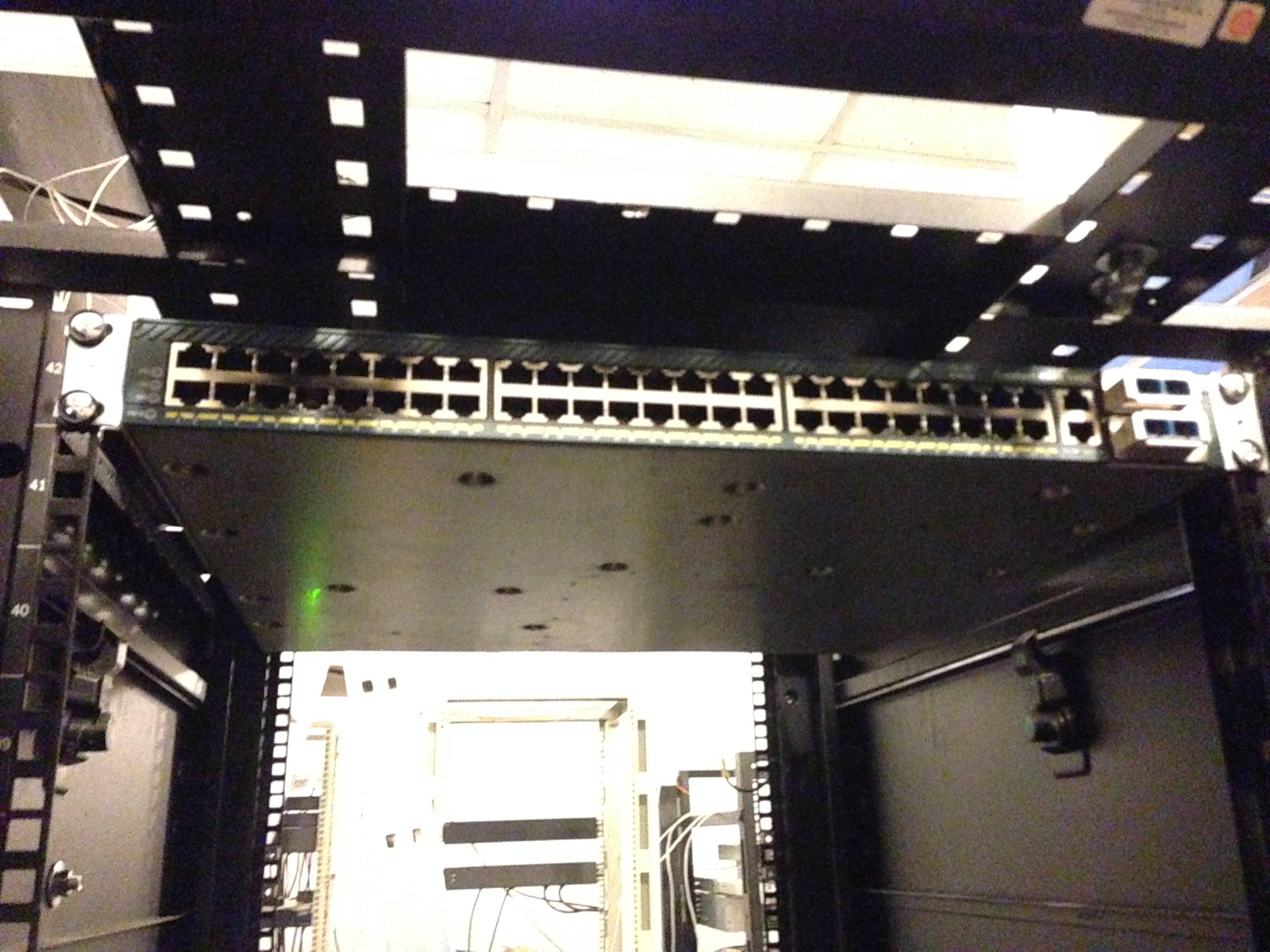

Мы арендовали шкаф в Днепропетровском дата-центре и приобрели Cisco 4948 10GE (на вырост) и первые три сервера HP Gen 6.

Выбор оборудования HP, впоследствии нам очень помог, за счет своего низкого энергопотребления. Ну а дальше, пошло-поехало. Приобрели управляемые розетки (PDU), они нам были важны для отсчета энергопотребления и управления серверами (авто-инсталл).

Уже потом мы поняли что взяли не те PDU которые управляются, а просто измерительные. Но благо HP имеет встроенное iLO (IPMI) и это нас спасло. Мы сделали всю автоматизацию системы при помощи IPMI (через DCI Manager). После был приобретен некоторый инструментарий для прокладки СКС и мы потихоньку начали строить нечто большее.

Здесь мы видим APC PDU (которые оказались не управляемыми), подключаем:

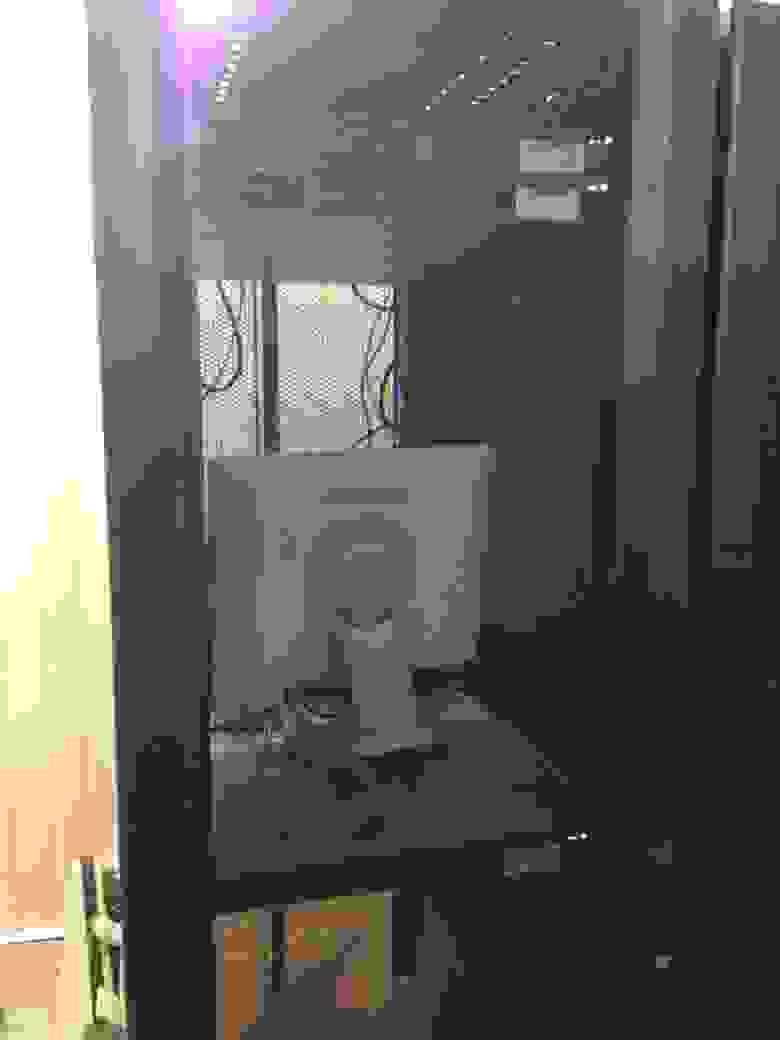

Вот так, кстати мы установили третий сервер и PDU (справа и слева). Сервер долго служил нам подставкой под монитор и клавиатуру с мышкой.

На имеющемся оборудовании мы организовали некий Cloud сервис при помощи VMmanager Cloud от компании ISP Systems. У нас было три сервера, один из которых был мастером, второй — файловым. Фактическое резервирование у нас было на случай падения одного из серверов (за исключением файлового). Мы понимали что 3 сервера для облака это мало, поэтому доп. оборудование уже было в пути. Благо «доставлять» в облако его можно было без проблем и особых настроек.

При падении одного из серверов (мастера, или второго резервного) — облако спокойно мигрировало туда и обратно без падений. Мы специально тестировали это перед вводом в продакшн. Файловый сервер у нас был организован на неплохих дисках в аппаратном RAID10 (для скорости и отказоустойчивости).

На тот момент у нас было несколько нод в России на арендованном оборудовании, которые мы бережно начали переносить на наш новый Cloud сервис. Очень много негатива было высказано поддержке компании ISP Systems, т.к. адекватной миграции из VMmanager KVM в VMmanager Cloud сделано ими не было, а по итогу нам вообще сказали что этого и не должно быть. Переносили ручками, долго и кропотливо. Разумеется перенесли лишь тех кто согласился на акционное размещение и перенос.

Примерно так мы работали еще около месяца, пока не заполнили оборудованием пол шкафа.

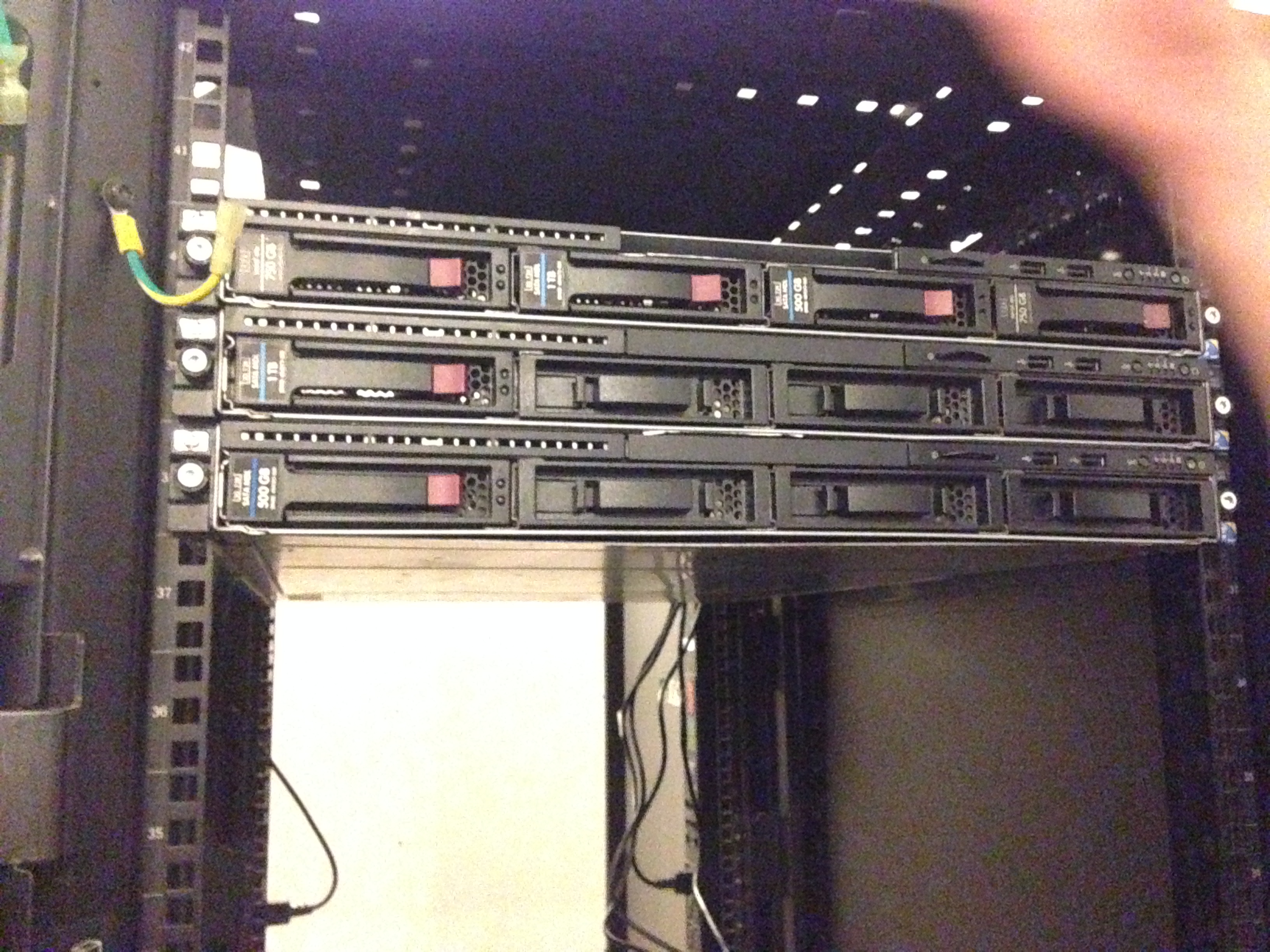

Так мы встречали вторую партию нашего оборудования, опять же HP (не реклама). Просто лучше иметь серверы которые взаимо-заменяемы, чем наоборот.

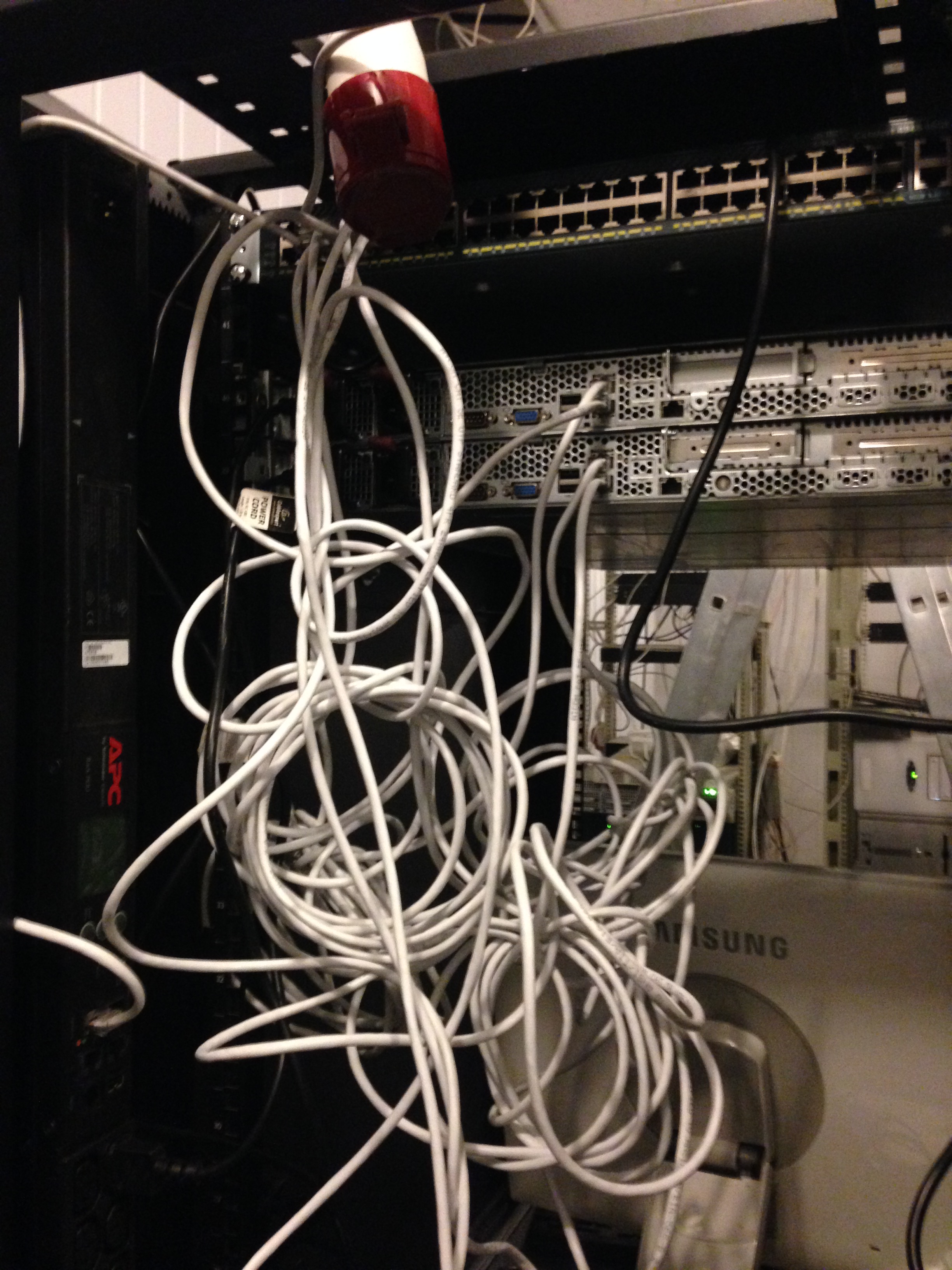

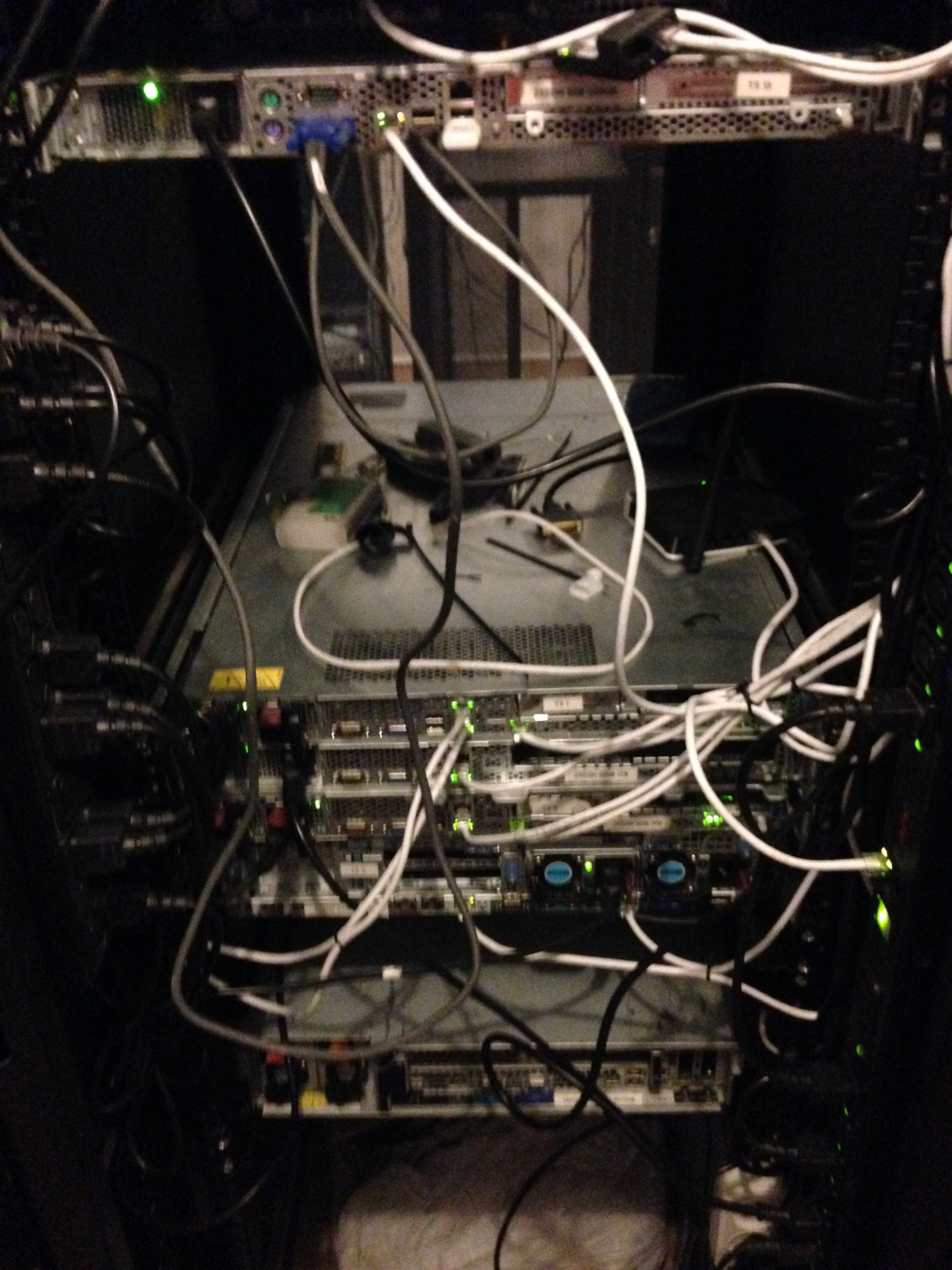

Исходя из того, что ни у кого из нас нет огромного опыта прокладки СКС (кроме администраторов, которые как обычно не там где нужно) — приходилось учиться всему на лету. Так у нас лежали провода первое время (около дня) когда мы устанавливали серверы.

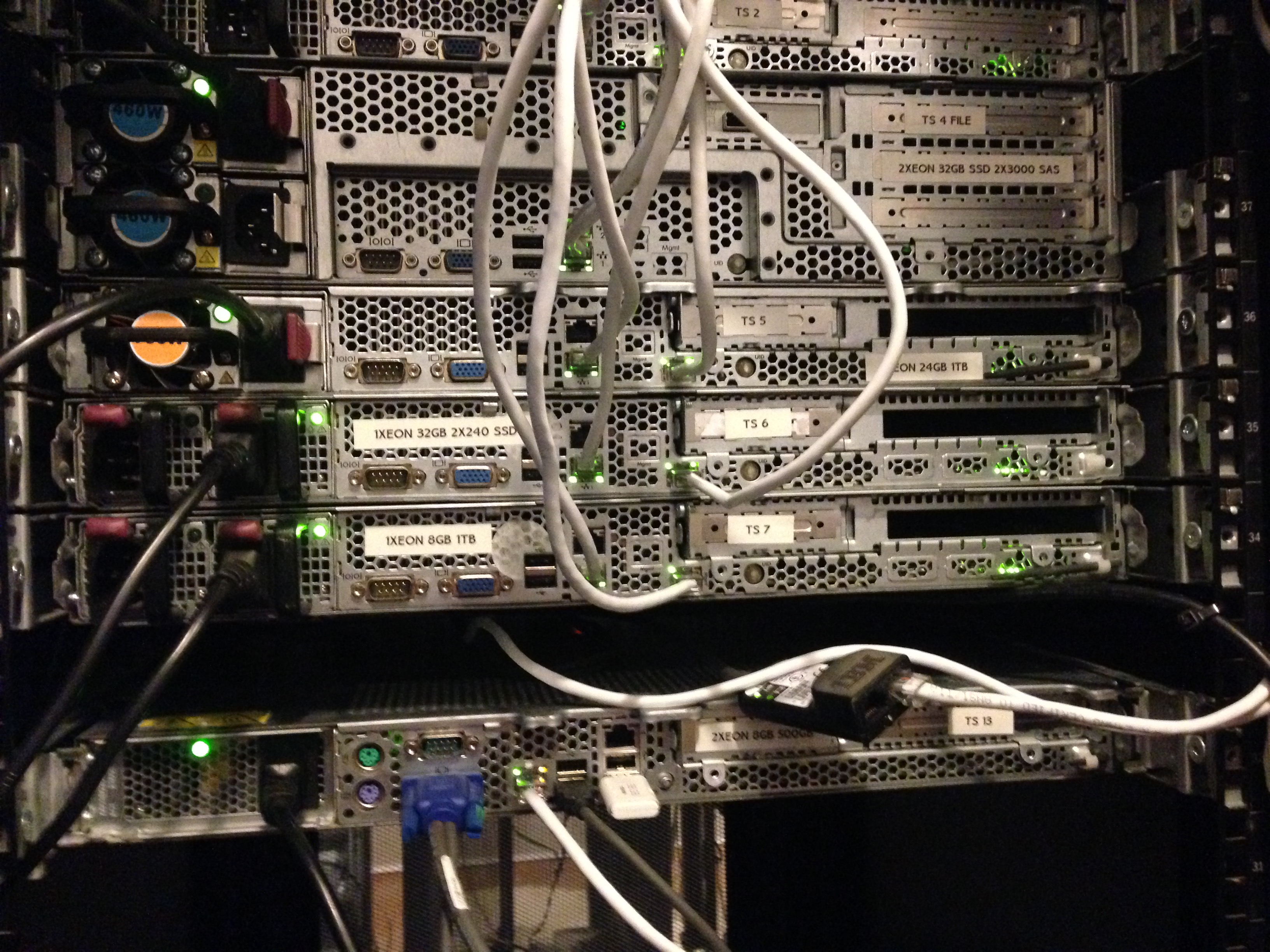

Примерно так — стало уже после установки всего пришедшего оборудования и прокладки.

По мере роста компании мы все чаще сталкивались с определенными трудностями. Были и проблемы с оборудованием (отсутствие в быстром доступе кабелей SAS-SATA), его подключением, разными тонкостями и с DDoS атаками на нас (прилетали и такие что клали весь ЦОД). Но одна из главных, по нашему мнению — нестабильность ЦОДа в котором мы арендовали шкаф под оборудование. Мы и сами то были, не сильно стабильны, но когда падает и цод в котором ты размещаешься — это совсем плохо.

Исходя из того что ЦОД находился в старом полу-заброшенном здании производственного комплекса — работал он соответственно. И несмотря на то, что его владелец прикладывал все усилия чтобы он работал стабильно (а это истинная правда, Александр действительно молодец и во многом нам помог по началу) — отключали то свет, то интернет. Наверное это нас и спасло. Это стало причиной, которая побудила нас (без имеющихся на то финансов) приступить к поиску помещения для собственного дата-центра и организовать переезд в него менее чем за 14 дней (с учетом подготовки помещения, протяжки оптики и всего прочего) Но об этом, уже в следующей части нашего рассказа. О спешном переезде, поиске помещения и строительстве мини-цода в котором мы сейчас и обитаем.

Как мы строили свой мини ЦОД. Часть 2 — Гермозона

P.S. В следующей части много интересного. От сложностей с переездом, ремонтом, протяжкой оптики по жилым кварталам, установкой автоматики, подключением ИБП и ДГУ и т.п.

Часть 2 — Гермозона

Часть 3 — Переезд

Поехали

В 2015 году, в Украине была создана хостинг-компания с большими амбициями на будущее и фактическим отсутствием стартового капитала. Оборудование мы арендовали в Москве, у одного из известных провайдеров (и по знакомству), это и дало нам начало развития. Благодаря нашему опыту и отчасти везению, уже в первые месяцы мы набрали достаточно клиентов, чтобы купить собственное оборудование и обзавестись хорошими связями.

Мы долго выбирали оборудование, которое нам нужно для собственных целей, выбирали сначала по параметрам цена/качество, но к сожалению большинство известных брендов (hp, dell, supermicro, ibm) все очень неплохи по качеству и схожи по цене.

Тогда мы пошли другим путем, выбирали из того что есть в Украине в наличии в больших количествах (на случай поломок или замены) и выбрали HP. Супермикро (как нам казалось) очень неплохо конфигурируются, но к сожалению их цена в Украине превышала всякий адекватный смысл. Да и запчастей было не так много. Так мы и выбрали, то что выбрали.

Первое железо

Мы арендовали шкаф в Днепропетровском дата-центре и приобрели Cisco 4948 10GE (на вырост) и первые три сервера HP Gen 6.

Выбор оборудования HP, впоследствии нам очень помог, за счет своего низкого энергопотребления. Ну а дальше, пошло-поехало. Приобрели управляемые розетки (PDU), они нам были важны для отсчета энергопотребления и управления серверами (авто-инсталл).

Уже потом мы поняли что взяли не те PDU которые управляются, а просто измерительные. Но благо HP имеет встроенное iLO (IPMI) и это нас спасло. Мы сделали всю автоматизацию системы при помощи IPMI (через DCI Manager). После был приобретен некоторый инструментарий для прокладки СКС и мы потихоньку начали строить нечто большее.

Здесь мы видим APC PDU (которые оказались не управляемыми), подключаем:

Вот так, кстати мы установили третий сервер и PDU (справа и слева). Сервер долго служил нам подставкой под монитор и клавиатуру с мышкой.

На имеющемся оборудовании мы организовали некий Cloud сервис при помощи VMmanager Cloud от компании ISP Systems. У нас было три сервера, один из которых был мастером, второй — файловым. Фактическое резервирование у нас было на случай падения одного из серверов (за исключением файлового). Мы понимали что 3 сервера для облака это мало, поэтому доп. оборудование уже было в пути. Благо «доставлять» в облако его можно было без проблем и особых настроек.

При падении одного из серверов (мастера, или второго резервного) — облако спокойно мигрировало туда и обратно без падений. Мы специально тестировали это перед вводом в продакшн. Файловый сервер у нас был организован на неплохих дисках в аппаратном RAID10 (для скорости и отказоустойчивости).

На тот момент у нас было несколько нод в России на арендованном оборудовании, которые мы бережно начали переносить на наш новый Cloud сервис. Очень много негатива было высказано поддержке компании ISP Systems, т.к. адекватной миграции из VMmanager KVM в VMmanager Cloud сделано ими не было, а по итогу нам вообще сказали что этого и не должно быть. Переносили ручками, долго и кропотливо. Разумеется перенесли лишь тех кто согласился на акционное размещение и перенос.

Примерно так мы работали еще около месяца, пока не заполнили оборудованием пол шкафа.

Так мы встречали вторую партию нашего оборудования, опять же HP (не реклама). Просто лучше иметь серверы которые взаимо-заменяемы, чем наоборот.

Исходя из того, что ни у кого из нас нет огромного опыта прокладки СКС (кроме администраторов, которые как обычно не там где нужно) — приходилось учиться всему на лету. Так у нас лежали провода первое время (около дня) когда мы устанавливали серверы.

Примерно так — стало уже после установки всего пришедшего оборудования и прокладки.

По мере роста компании мы все чаще сталкивались с определенными трудностями. Были и проблемы с оборудованием (отсутствие в быстром доступе кабелей SAS-SATA), его подключением, разными тонкостями и с DDoS атаками на нас (прилетали и такие что клали весь ЦОД). Но одна из главных, по нашему мнению — нестабильность ЦОДа в котором мы арендовали шкаф под оборудование. Мы и сами то были, не сильно стабильны, но когда падает и цод в котором ты размещаешься — это совсем плохо.

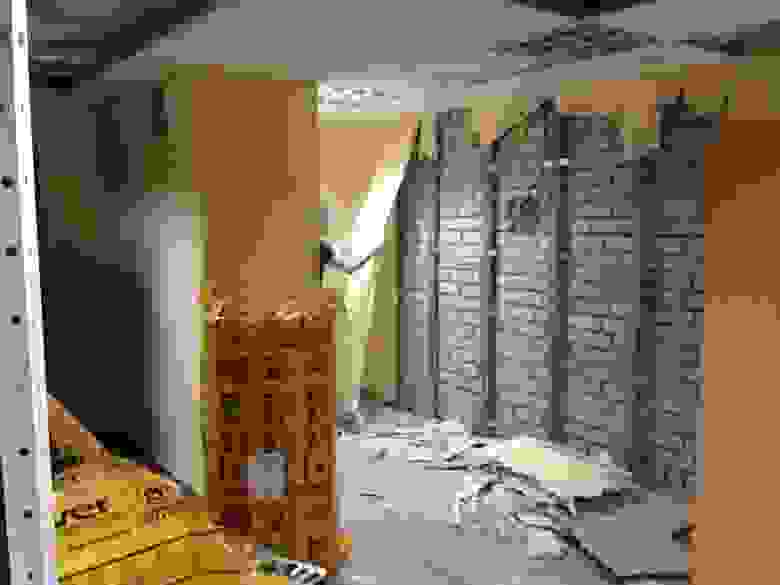

Исходя из того что ЦОД находился в старом полу-заброшенном здании производственного комплекса — работал он соответственно. И несмотря на то, что его владелец прикладывал все усилия чтобы он работал стабильно (а это истинная правда, Александр действительно молодец и во многом нам помог по началу) — отключали то свет, то интернет. Наверное это нас и спасло. Это стало причиной, которая побудила нас (без имеющихся на то финансов) приступить к поиску помещения для собственного дата-центра и организовать переезд в него менее чем за 14 дней (с учетом подготовки помещения, протяжки оптики и всего прочего) Но об этом, уже в следующей части нашего рассказа. О спешном переезде, поиске помещения и строительстве мини-цода в котором мы сейчас и обитаем.

Как мы строили свой мини ЦОД. Часть 2 — Гермозона

P.S. В следующей части много интересного. От сложностей с переездом, ремонтом, протяжкой оптики по жилым кварталам, установкой автоматики, подключением ИБП и ДГУ и т.п.