Сразу скажу главное — заявление про «цену дисковой» касается только специальных акционных цен на Unity, которые EMC дало нам как официальному партнеру в России под промо новой модели СХД. Акция касается не всех, детали в почту. Обычные же цены — просто крепкий хороший midrange под свою специфику.

Итак, поехали. EMC уже много лет неравнодушна к флешам, но в прошлом году конкретно заморочилась, решив, что будущее за ним. И выпустило рабочую и не очень дорогую штуку. Это почти что обычный мидрейндж с SSD-дисками (нюансы чуть позже). Никаких «втыкаем лом, а она продолжает работать», но зато внушительная производительность под базы данных и виртуалки плюс разные мелкие фишки.

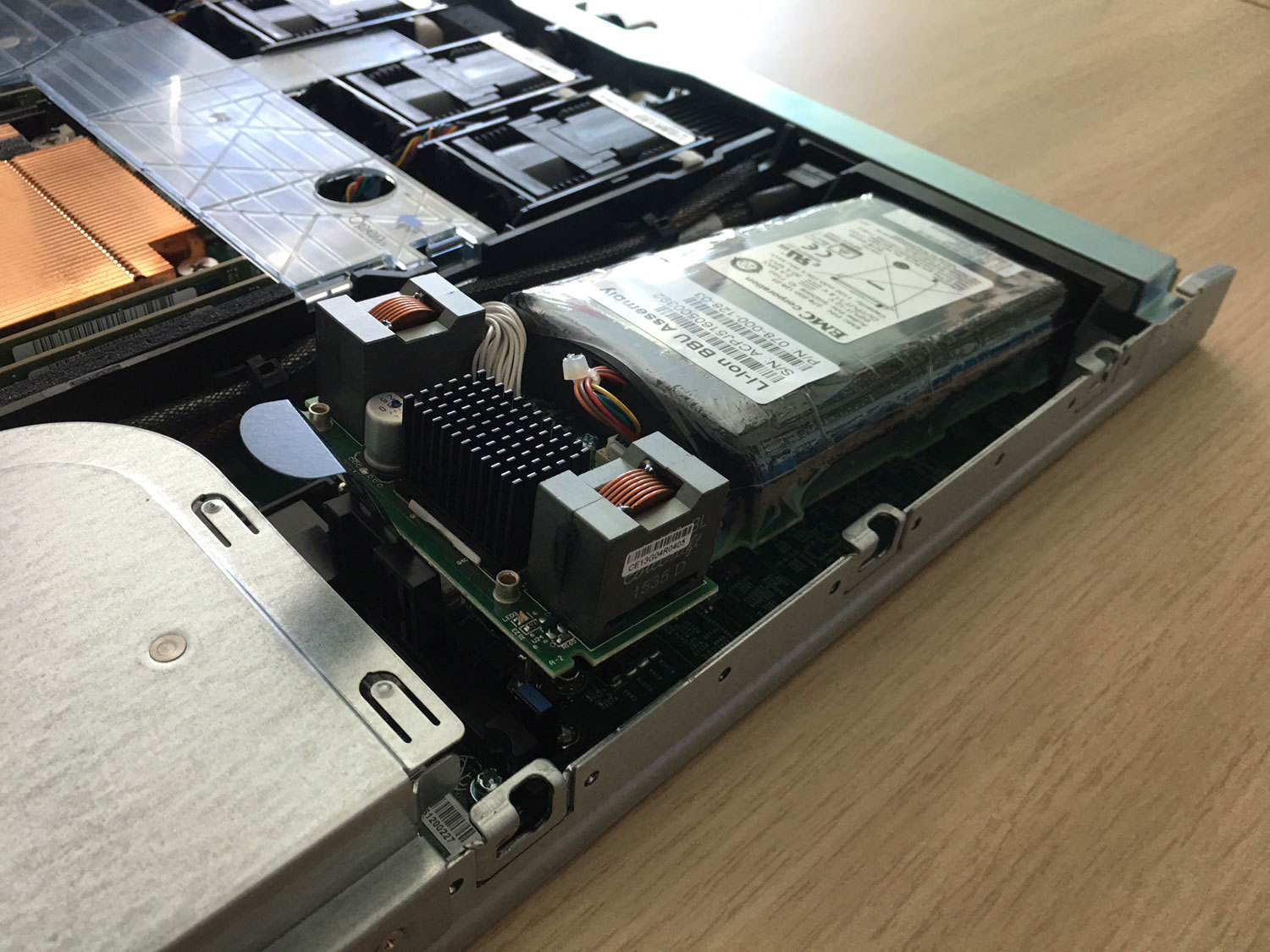

Вот яркий пример оптимизации — раньше тут был отдельный ИБП-модуль в своём кожухе, и он менялся «на горячую». А теперь — Li-ion батарея с полиэтиленовой защитой от протечки внутри контроллера.

А ещё они наступили многим вендорам на любимую мозоль и сделали цену поддержки одинаковой на всё время. А то, знаете ли, многие большие вендоры любят ставить такую цену на 4-й и 5-й год, что проще заменить железо на новое. Ну и да, у этих ребят выход из строя диска по износу считается гарантийным случаем, не в пример некоторым любителем звездочек и мелкого шрифта в гарантийной политике.

Всё, теперь пошли втыкать в неё лом и тестировать. Забегая вперёд скажу, что с 9 дисков сняли 80 тысяч иопсов.

Главный вопрос — что будет с линейкой СХД после объединения. Больше всего спрашивали, причём звонили даже те, у кого железки трёхлетней давности. Официального сообщения пока нет, но ЕМС в сегменте мид-рейнджа всегда лидировала, и здесь Делл не будет рубить курицу, которая несет золотые яйца. И выход нового Юнити — этому подтверждение.

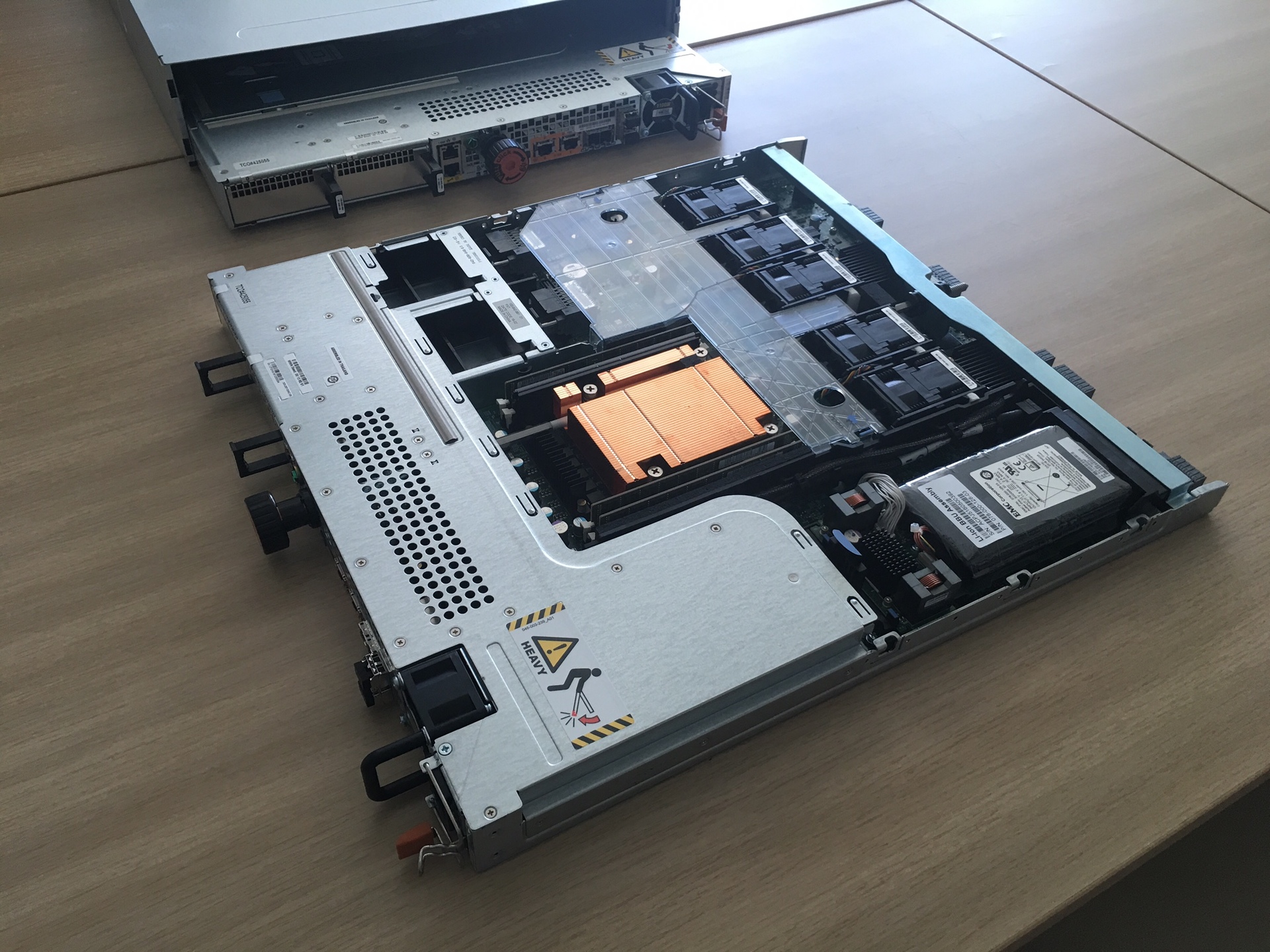

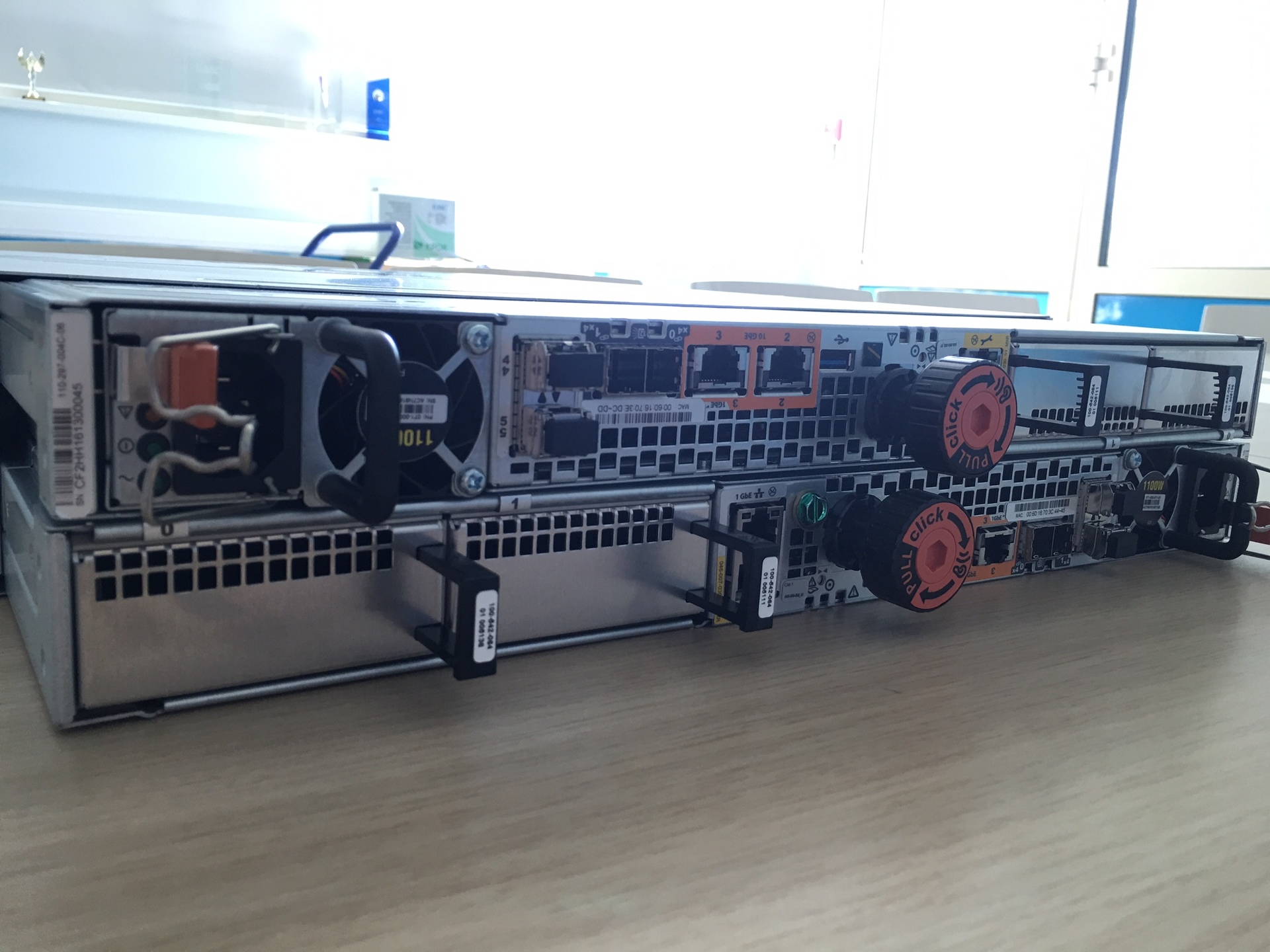

Чёрные блоки справа вверху — охлаждение (флеш-штука горячая, постоянно нужно дуть), дальше батарея, в середине вся начинка и процессор (вот видно DIMM около оранжевого блока), левее в Г-образном кожухе — блок питания, еще вентиляторы (не забываем дуть на проц) и место под IO-модули.

Юнити сама по себе — это замена текущих VNX с точки зрения маркетинга. Железо тут стандартное, два контроллера на базе процессоров х86 плюс полки с SSD-дисками, подключаемые по шине SAS3. А вот микрокод здесь сильно переработанный (причем его частично писали русские программеры из Питера), ровно как и новые алгоритмы работы с дисками. Подход был нестандартный: хоть в линейке и есть и флешовые, и гибридные системы, разработка шла от all-flash, а уже потом делалась совместимость с HDD (благо это вопрос изученный). То есть оверхед, конечно, поверх SSD есть (нет его только там, где вместо дисков используются голые микросхемы флеш-фабрики, а это вообще другие цены), но задержки и производительность очень хорошо получилось оптимизировать.

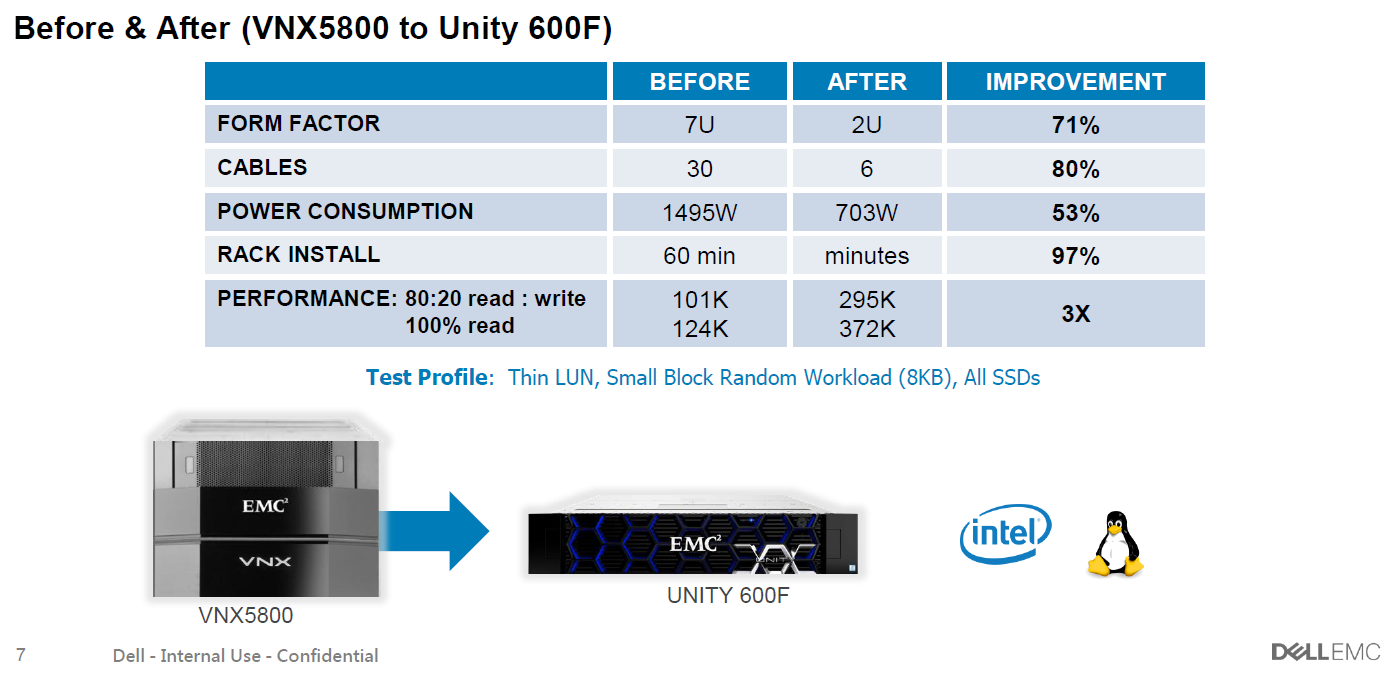

Только не читайте мелкую подпись :)

Главная мотивация распрощаться со шпинделями — это цена. На досуге я считал цену на гибридную СХД и all-flash — разлёт получается 30-40% с учетом скидок (на флеш они больше). Это уже не порядок, как раньше, и, значит, можно думать об использовании их там, где раньше бегали НЖМД. Да и дико это — вспоминаю, как приходилось по 100 шпинделей набирать для производительности, а потом еще их объем резать, т.к. получались лишние терабайты. И еще штрафняки на RAID не забыть вычесть. А бывает, приходит заказчик с запросом на 10-15 тысяч IOPS с базенки на 3-4 Тб. И что прикажете – 300Гб 15к в зеркало??? Сейчас в линейке SSDшки от 400 ГБ до 15 (!) ТБ. В общем, считать нужно под задачу. Обращайтесь, контакты внизу. Но что-то я отвлекся.

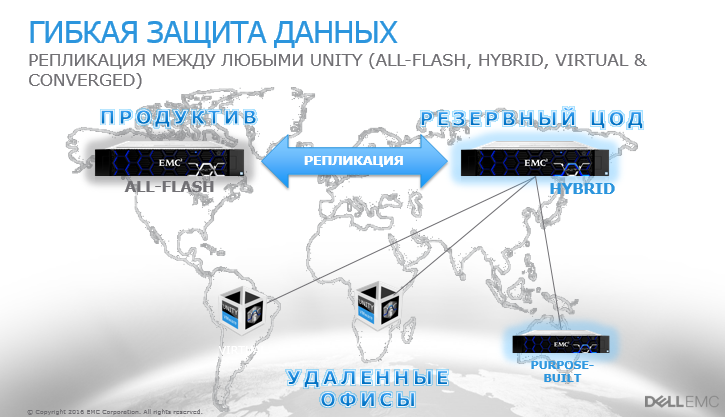

Не забыли архитекторы и про мелкие филиалы компаний. Есть версия в виде виртуальной машины под Vmware (обещают и другие гипервизоры подтянуть, если будет спрос), которая ставится в далёкий маленький филиал поверх сервера с дисками или совсем простой полкой, и после этого всё его пространство будут видеться как полноценная СХД Unity. это дает такие возможности, как репликация из филиалов, снапшоты и управление из единого окна. Потому и Unity, собственно.

Раньше к железу надо было отдельно докупать лицензию на ёмкость. Для многих заказчиков это было неудобно. Сейчас этого нет. И нету отдельных продуктов — репликация, блочные и файловые протоколы, снепшоты, тиринг и фасткэш (для гибридных систем) включены в поставку.

На all-flash постоянно спрашивают про надежность — и вот EMC сделали вывод, что флешовые системы поддерживать вполне себе нормально, потому что флеш почти вечный, ибо без движущихся частей и изнашивается ну очень медленно. И потому цена одинаковая для каждого года поддержки, как я уже говорил (но это не относится к гибридным хранилищам). Ещё вкусное — опять же, упоминал, пока массив на гарантии или расширенной гарантии — если диск выйдет из строя по причине износа, они его поменяют неважно на каком году. У другого небезызвестного вендора это считается за проблему заказчика и негарантийным случаем. Тоже нашли кому наступить на мозоль.

Очень удобно по объёму — можно хоть 200 Тб в одну полку запихнуть, если надо. В сравнении со шпиндельными хранилками очень даже приятно.

Есть у нас уже и боевые внедрения — несмотря на майский релиз железки. Заказчик раскинул ROI, TCO и понял, что гибрид брать не выгодно. В итоге там Юнити 400F (F – значит Flash) 47 SSD по 1,6, получается около 60 Тб полезного места в RAID5. Всё это в 4 юнитах. Выдаёт 140 тысяч iops.

В целом система, как обычно, сделана по-ирландски (у них завод в Корке в Ирландии). Сборка аккуратная и красивая, но очень своеобразная по решениям. Например, контроллеры (два лезвия) крепятся к шасси здоровенным болтом, который проходит через весь массив. Благодаря этой оси все разъемы ровно входят друг в друга на бэкплейне.

Вот эти болты. Пока их аккуратно докручиваешь на последнем сантиметре, ощущение как при стыковке с МКС.

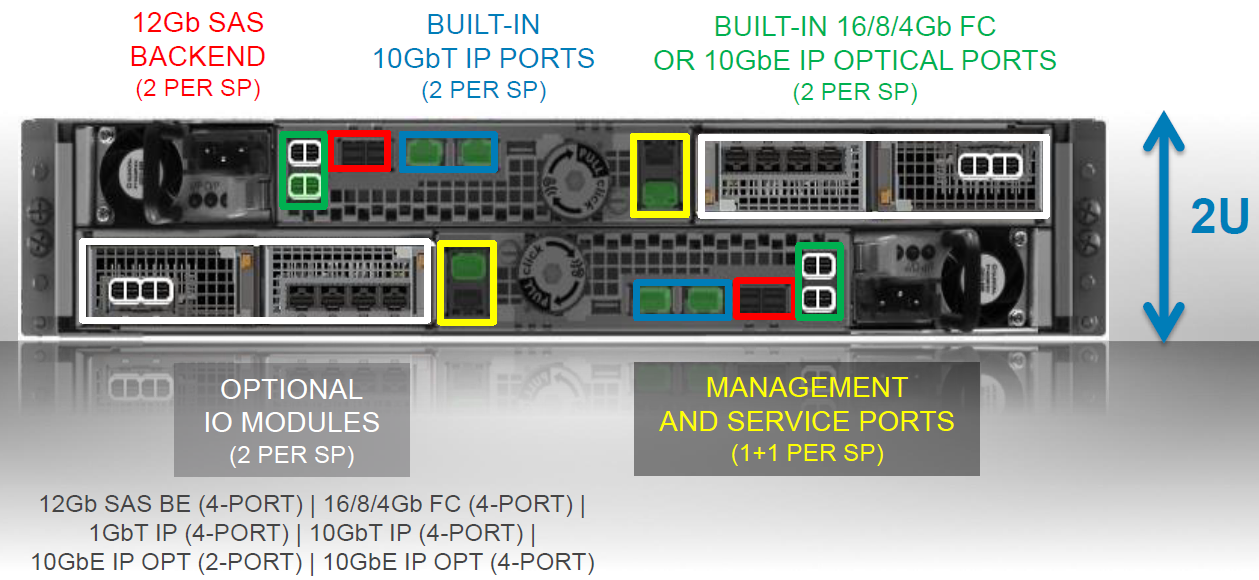

На борту есть встроенный 10 BASE-T для раздачи по файловым протоколам или блочного iSCSI. Он дешёвый, поэтому не удорожает конструкцию, но пользу несомненно принесет. А вот основной коммуникационный порт вы выбираете под свою инфраструктуру. При заказе можно выбрать какие трансиверы пойдут в конвергентный разъем ввода-вывода (16 FC либо 10 Eth / ISCSI). Их по 2 на контроллер. Надо больше — есть модуль расширения, куда этих портов можно добить. См. схему ниже. И никаких отдельных файловых контроллеров — всё уже на борту. Это чертовски удобно, надо сказать, хотя скорее актуально для гибридных моделей, чем полностью твердотельных. Всё-таки для файлопомоек флеш пока еще дороговат. Ну или же для любителей строить Vmware на NFS, что очень популярно в последнее время.

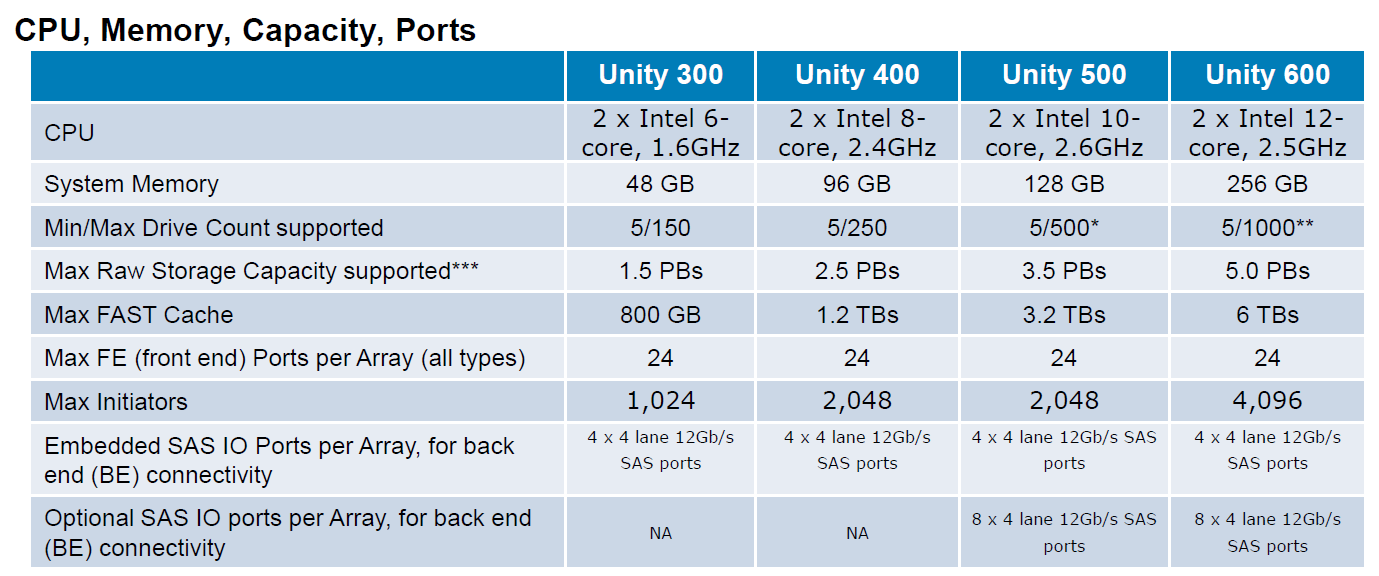

Процессоры и память не вызывают удивления — старый добрый Интел.

Внутри два SSD для сброса грязного кэша при отключении питания, в каждом контроллере они свои. ОС ставится на первые 4 диска. Порадую тех, кто знаком с предыдущими линейками от ЕМС: эти диски теперь можно объединять со всеми остальными в пул под данные. Раньше они часто становились мертвым грузом, на которые кроме образов виртуальных машин нечего было положить. Да и вендор крайне не рекомендовал их нагружать. Сейчас — пожалуйста. Только для высоконагруженных инсталляций мы всё же рекомендуем придерживаться этого старого правила. Они поэтому и системные, что важные. А без нагрузки ребилд всегда быстрее проходит. Ребилд 1.6Тб диска под нагрузкой 50т IOPS, кстати, занял чуть меньше двух часов. Результат этот видится мне вполне достойным.

2 кабеля питания (чёрный и серый по краям), 2 управляющих (по зелёному в юнит), 2 frontend (синие).

У хорошего джедая меч синий, а у очень хорошего — серебистый: обратите внимание на логотипы. За внимание к деталям производителю отдельный плюс в карму.

Тестировали стандартным в последнее время для нас методом от rpokruchin.

Результаты получились следующие:

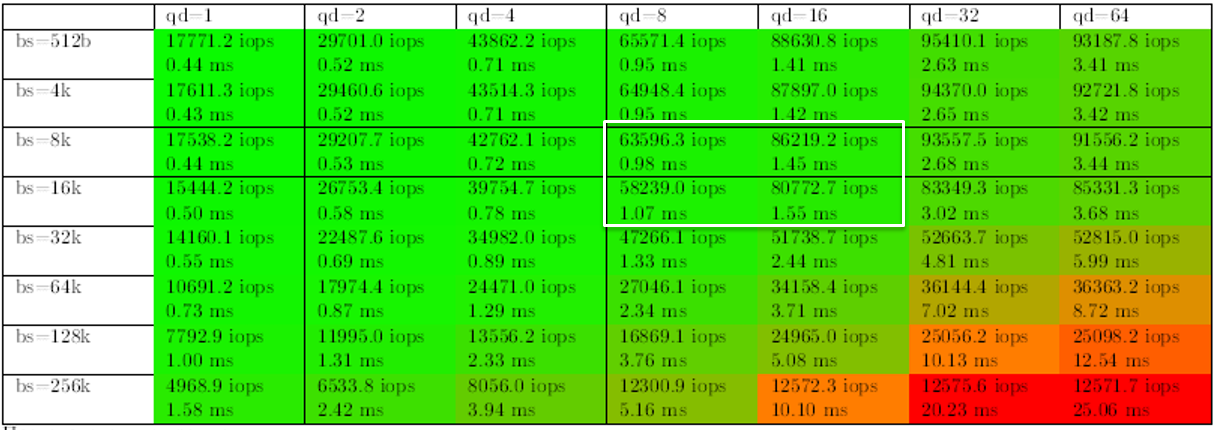

1. Начнем с характерных для SSD нагрузок – случайного чтения и записи. Выделил значения, которые можно принять за эталон. Кстати, видно, что система внутри себя работает блоком 8К, т.к. количество IOPS начинает уменьшаться только при бОльшем размере, а на меньших показывает практически тот же результат. Если подходить к вопросу строго, то результат на случайном чтении – 63,5 тысячи IOPS (когда принимаем 1мс за отсечку и всё, что выше — не в счет). Если на это внимание не акцентировать, то можно считать, что 86 тысяч мы из нее выжали. Хотя каждый волен решать сам, какие результаты считать правильными. Для этого и приведена вся таблица на разных блоках и очередях:

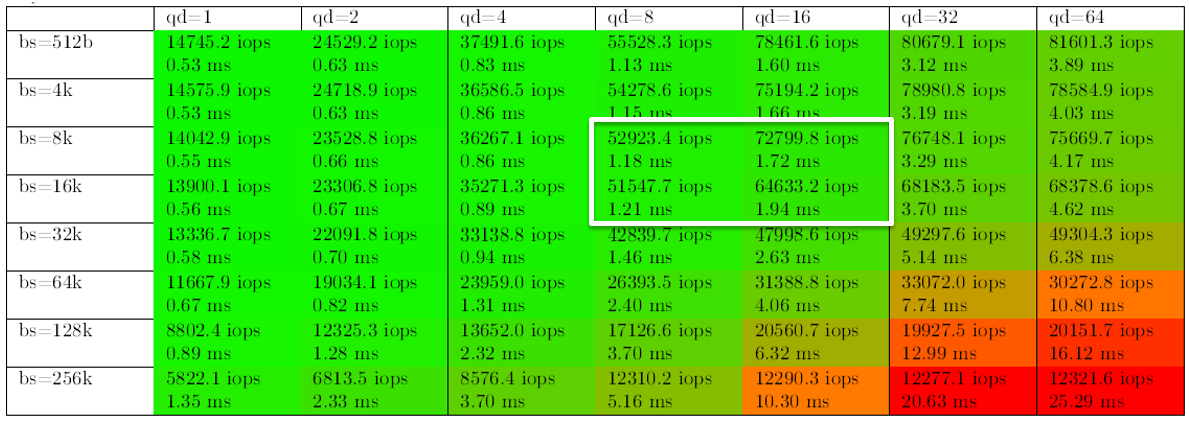

Что интересно, на случайной записи результаты оказались лучше, чем мы думали. Производительность получилась хуже только на 20%. Может быть, конечно, кэш СХД отработал на пятерку, хотя всячески старались его обойти разве только что не выключали. Но это было бы неверно, т.к. его не для того включили в дизайн, чтобы лихие парни из КРОКа его гасили. Да и в продуктиве всё равно он будет включен.

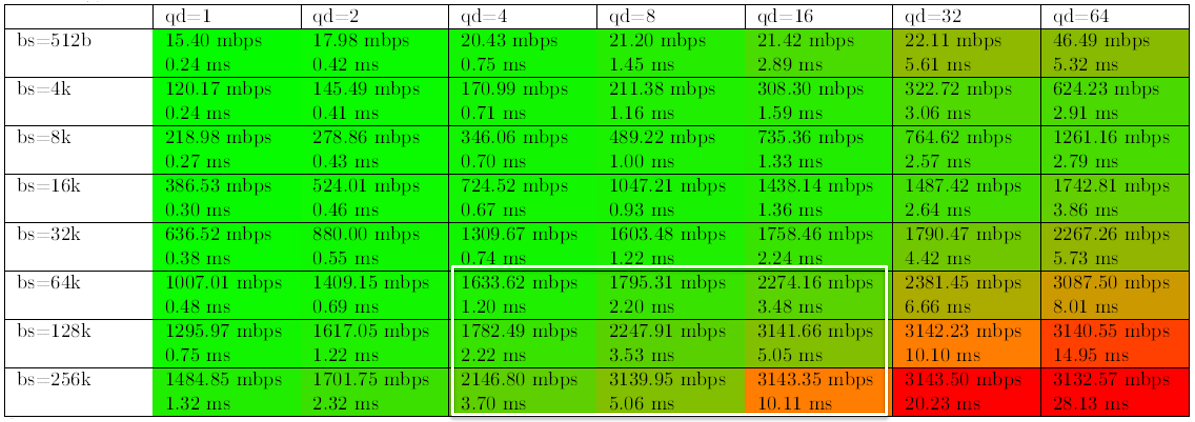

Не оставили без внимания также нагрузки при бэкапах, когда идет последовательное чтение большим блоком и важна скорее пропускная способность, нежели время отклика и иопсы (кто захочет кинуть в меня кирпичом, заранее соглашусь, что да, при бэкапах блок может быть еще больше, но общей картины это не меняет):

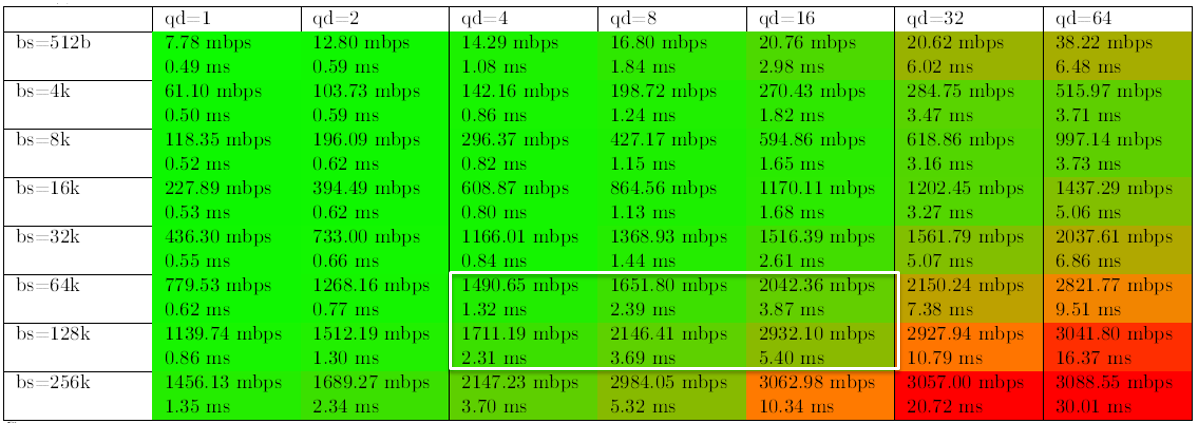

И, наконец, нагрузка, характерная для заливки данных — последовательная запись большими блоками.

Из таблицы можно заметить, что после определенного момента производительность уже не растет, а вот время отклика увеличивается. Тут приходится вспомнить, что всё-таки система мидрейнджовая, и звезд с небес не обещала. Тем более на 9 дисках, из которых 4 системных (Да, мы плохие ребята, не следуем своим же лучшим практикам). Просто нужно знать с самого начала ее потолок и следить за своим продуктивом. Чем выше модель в линейке — тем выше её потолок. Он, кстати, почти честно указан в даташите (есть в ссылках ниже). Это нужно учитывать при покупке.

Что интересно, конечно, на высокие показатели она выходит на небольшом количестве дисков — с увеличением количества дисков она быстро упрется в обозначенный потолок и дальше производительность расти не будет, но зато за свои деньги работает. Как мы поняли — причина в том, что система упирается в мощность контроллера. На логичный вопрос был получен ответ — за все в этой жизни надо платить. В случае если нужна производительность больше — нужна большая модель.

Конечно, когда смотришь на свободные слоты для плашек памяти на материнке, хочется добавить туда несколько серверных планок по несколько сотен долларов и получить дополнительный кэш (кэш там – обычные DIMM по 16 Gb). Или поменять процессоры тоже заодно (в младшей модели шестиядерные 1,6 Ггц). Но такое действие снимет желзку и гарантии сразу, увы. Правда, я знаю человека, который как-то умудрился снять со своей СХД систему магнитного уничтожения дисков и выдать полный отказ за гарантийный случай, поэтому, может, кто-то их и будет переставлять перед приездом инженеров, но что-то маловероятно.

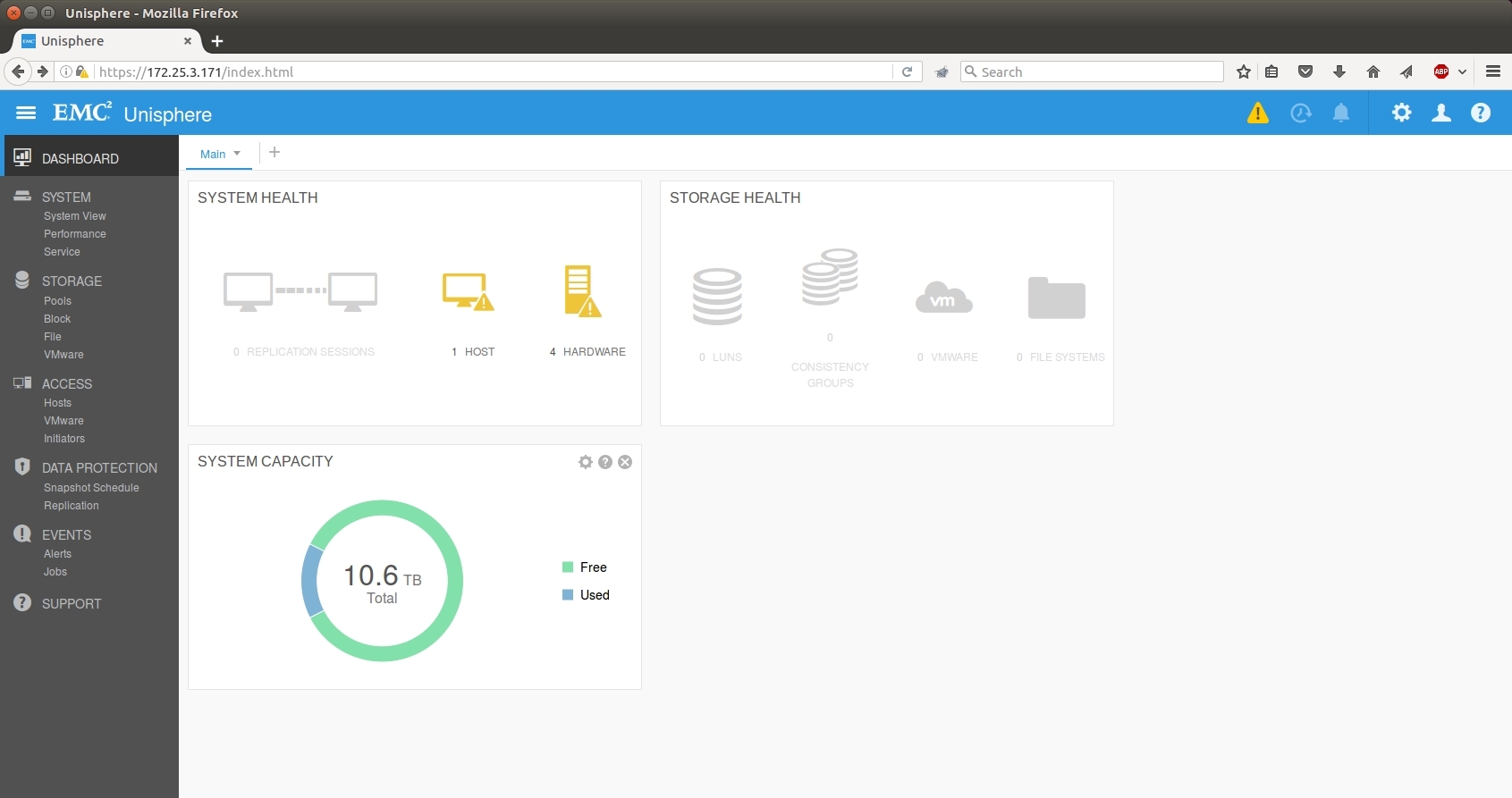

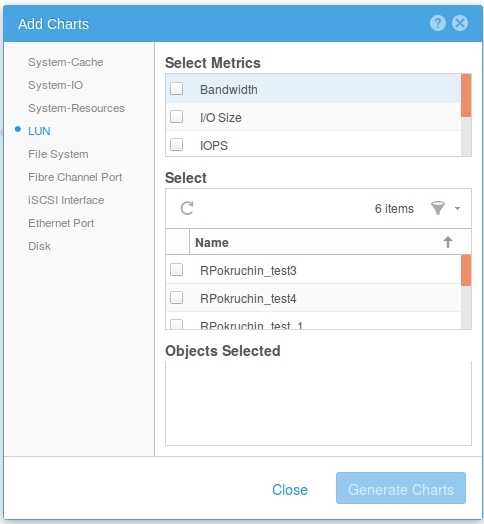

Теперь на HTML 5. GUI отлично работает на Windows и Linux, для ценителей автоматизации есть cli и REST API. Очень много сил было приложено к оптимизации. Выполнение задач реально легче. Удобные визарды пришли на смену беготне по нескольким вкладкам. Realt-time и историческую статистику производительности можно смотреть в онлайн режиме без использования дополнительных утилит. Графики настраиваются в том же интерфейсе, управление очень гибкое.

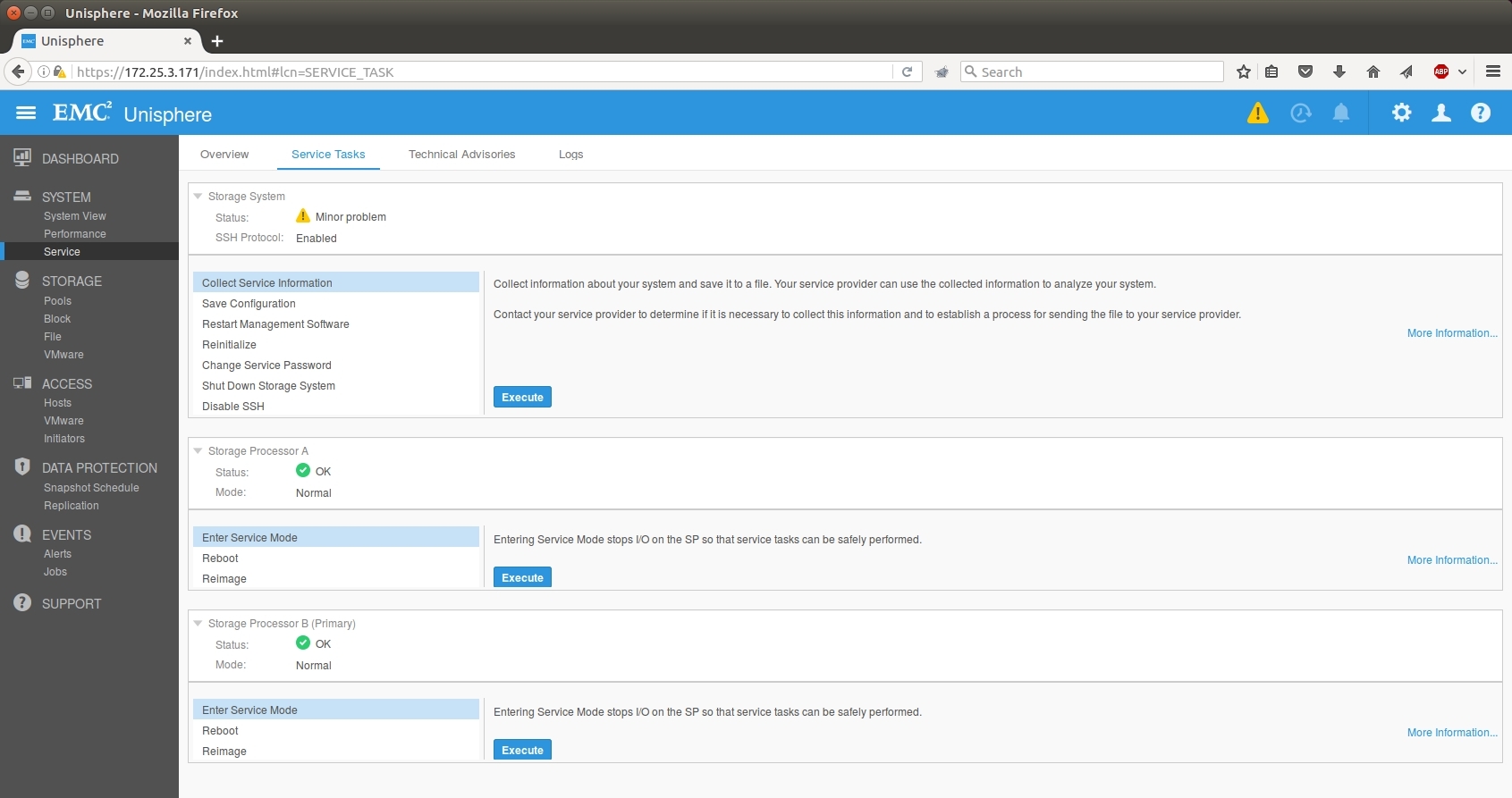

Помимо административных задач очень упростились сервисные операции. Все они теперь собраны в одной вкладке. Логи с массива собираются быстрее и сразу с обоих контроллеров. В Web GUI появились такие операции как Reimage и обновление кода массива \ дисков.

Есть управление из облака: при желании можно зарегаться в специальном сервисе, куда система будет сливать свои счетчики — будут предлагаться советы по оптимизации ресурсов и управлению. Сделано это, конечно, для того, чтобы вы не пропустили апргейд и дозакупку железа, но, вроде, польза тоже есть.

Есть еще классные тулзы у партнеров по оценке текущей инфраструктуры — можно собрать логи с ваших массивов, проанализировать и на выходе узнать, какая Юнити с учетом роста на 3-5 лет заменит все текущие массивы. И плюс к этому можно понять, нужен ли allflash или гибридной достаточно.

С виртуальной Unity можно поиграть — она скачивается в виде демки с лицензией на некоммерческое использование бесплатно по этой ссылке.

Производитель поставил себя на место заказчика и учел свои ошибки: выпустил достойную по производительности хранилку, упростил интерфейс и лицензирование и обеспечил прогнозируемую стоимость владения за счет фиксированной стоимости поддержки.

В дополнение к традиционно высокому качеству продуктов и сервиса можно смело говорить, что система достойна внимания корпоративных заказчиков практически любого уровня. Единственный вопрос — что будет с EMC в свете объединения с Dell. Лично я думаю, что всё так и останется, но это, как говорится, одному Деллу известно.

Вот так сейчас может выглядеть 100Тб флеша

Система была выпущена в мае, у нас есть положительный опыт месячных тестов и внедрения у заказчиков (один из примеров выше). По секрету скажу, что помимо тестовой мы «под шумок» еще купили для своей инфраструктуры одну гибридную и одну флешовую систему и уже эксплуатируем их под внутренние задачи.

Итак, поехали. EMC уже много лет неравнодушна к флешам, но в прошлом году конкретно заморочилась, решив, что будущее за ним. И выпустило рабочую и не очень дорогую штуку. Это почти что обычный мидрейндж с SSD-дисками (нюансы чуть позже). Никаких «втыкаем лом, а она продолжает работать», но зато внушительная производительность под базы данных и виртуалки плюс разные мелкие фишки.

Вот яркий пример оптимизации — раньше тут был отдельный ИБП-модуль в своём кожухе, и он менялся «на горячую». А теперь — Li-ion батарея с полиэтиленовой защитой от протечки внутри контроллера.

А ещё они наступили многим вендорам на любимую мозоль и сделали цену поддержки одинаковой на всё время. А то, знаете ли, многие большие вендоры любят ставить такую цену на 4-й и 5-й год, что проще заменить железо на новое. Ну и да, у этих ребят выход из строя диска по износу считается гарантийным случаем, не в пример некоторым любителем звездочек и мелкого шрифта в гарантийной политике.

Всё, теперь пошли втыкать в неё лом и тестировать. Забегая вперёд скажу, что с 9 дисков сняли 80 тысяч иопсов.

Объединение Dell и EMC

Главный вопрос — что будет с линейкой СХД после объединения. Больше всего спрашивали, причём звонили даже те, у кого железки трёхлетней давности. Официального сообщения пока нет, но ЕМС в сегменте мид-рейнджа всегда лидировала, и здесь Делл не будет рубить курицу, которая несет золотые яйца. И выход нового Юнити — этому подтверждение.

Что за железка и как сделана

Чёрные блоки справа вверху — охлаждение (флеш-штука горячая, постоянно нужно дуть), дальше батарея, в середине вся начинка и процессор (вот видно DIMM около оранжевого блока), левее в Г-образном кожухе — блок питания, еще вентиляторы (не забываем дуть на проц) и место под IO-модули.

Юнити сама по себе — это замена текущих VNX с точки зрения маркетинга. Железо тут стандартное, два контроллера на базе процессоров х86 плюс полки с SSD-дисками, подключаемые по шине SAS3. А вот микрокод здесь сильно переработанный (причем его частично писали русские программеры из Питера), ровно как и новые алгоритмы работы с дисками. Подход был нестандартный: хоть в линейке и есть и флешовые, и гибридные системы, разработка шла от all-flash, а уже потом делалась совместимость с HDD (благо это вопрос изученный). То есть оверхед, конечно, поверх SSD есть (нет его только там, где вместо дисков используются голые микросхемы флеш-фабрики, а это вообще другие цены), но задержки и производительность очень хорошо получилось оптимизировать.

Только не читайте мелкую подпись :)

Главная мотивация распрощаться со шпинделями — это цена. На досуге я считал цену на гибридную СХД и all-flash — разлёт получается 30-40% с учетом скидок (на флеш они больше). Это уже не порядок, как раньше, и, значит, можно думать об использовании их там, где раньше бегали НЖМД. Да и дико это — вспоминаю, как приходилось по 100 шпинделей набирать для производительности, а потом еще их объем резать, т.к. получались лишние терабайты. И еще штрафняки на RAID не забыть вычесть. А бывает, приходит заказчик с запросом на 10-15 тысяч IOPS с базенки на 3-4 Тб. И что прикажете – 300Гб 15к в зеркало??? Сейчас в линейке SSDшки от 400 ГБ до 15 (!) ТБ. В общем, считать нужно под задачу. Обращайтесь, контакты внизу. Но что-то я отвлекся.

Не забыли архитекторы и про мелкие филиалы компаний. Есть версия в виде виртуальной машины под Vmware (обещают и другие гипервизоры подтянуть, если будет спрос), которая ставится в далёкий маленький филиал поверх сервера с дисками или совсем простой полкой, и после этого всё его пространство будут видеться как полноценная СХД Unity. это дает такие возможности, как репликация из филиалов, снапшоты и управление из единого окна. Потому и Unity, собственно.

Раньше к железу надо было отдельно докупать лицензию на ёмкость. Для многих заказчиков это было неудобно. Сейчас этого нет. И нету отдельных продуктов — репликация, блочные и файловые протоколы, снепшоты, тиринг и фасткэш (для гибридных систем) включены в поставку.

На all-flash постоянно спрашивают про надежность — и вот EMC сделали вывод, что флешовые системы поддерживать вполне себе нормально, потому что флеш почти вечный, ибо без движущихся частей и изнашивается ну очень медленно. И потому цена одинаковая для каждого года поддержки, как я уже говорил (но это не относится к гибридным хранилищам). Ещё вкусное — опять же, упоминал, пока массив на гарантии или расширенной гарантии — если диск выйдет из строя по причине износа, они его поменяют неважно на каком году. У другого небезызвестного вендора это считается за проблему заказчика и негарантийным случаем. Тоже нашли кому наступить на мозоль.

Очень удобно по объёму — можно хоть 200 Тб в одну полку запихнуть, если надо. В сравнении со шпиндельными хранилками очень даже приятно.

Есть у нас уже и боевые внедрения — несмотря на майский релиз железки. Заказчик раскинул ROI, TCO и понял, что гибрид брать не выгодно. В итоге там Юнити 400F (F – значит Flash) 47 SSD по 1,6, получается около 60 Тб полезного места в RAID5. Всё это в 4 юнитах. Выдаёт 140 тысяч iops.

В целом система, как обычно, сделана по-ирландски (у них завод в Корке в Ирландии). Сборка аккуратная и красивая, но очень своеобразная по решениям. Например, контроллеры (два лезвия) крепятся к шасси здоровенным болтом, который проходит через весь массив. Благодаря этой оси все разъемы ровно входят друг в друга на бэкплейне.

Вот эти болты. Пока их аккуратно докручиваешь на последнем сантиметре, ощущение как при стыковке с МКС.

На борту есть встроенный 10 BASE-T для раздачи по файловым протоколам или блочного iSCSI. Он дешёвый, поэтому не удорожает конструкцию, но пользу несомненно принесет. А вот основной коммуникационный порт вы выбираете под свою инфраструктуру. При заказе можно выбрать какие трансиверы пойдут в конвергентный разъем ввода-вывода (16 FC либо 10 Eth / ISCSI). Их по 2 на контроллер. Надо больше — есть модуль расширения, куда этих портов можно добить. См. схему ниже. И никаких отдельных файловых контроллеров — всё уже на борту. Это чертовски удобно, надо сказать, хотя скорее актуально для гибридных моделей, чем полностью твердотельных. Всё-таки для файлопомоек флеш пока еще дороговат. Ну или же для любителей строить Vmware на NFS, что очень популярно в последнее время.

Процессоры и память не вызывают удивления — старый добрый Интел.

Внутри два SSD для сброса грязного кэша при отключении питания, в каждом контроллере они свои. ОС ставится на первые 4 диска. Порадую тех, кто знаком с предыдущими линейками от ЕМС: эти диски теперь можно объединять со всеми остальными в пул под данные. Раньше они часто становились мертвым грузом, на которые кроме образов виртуальных машин нечего было положить. Да и вендор крайне не рекомендовал их нагружать. Сейчас — пожалуйста. Только для высоконагруженных инсталляций мы всё же рекомендуем придерживаться этого старого правила. Они поэтому и системные, что важные. А без нагрузки ребилд всегда быстрее проходит. Ребилд 1.6Тб диска под нагрузкой 50т IOPS, кстати, занял чуть меньше двух часов. Результат этот видится мне вполне достойным.

2 кабеля питания (чёрный и серый по краям), 2 управляющих (по зелёному в юнит), 2 frontend (синие).

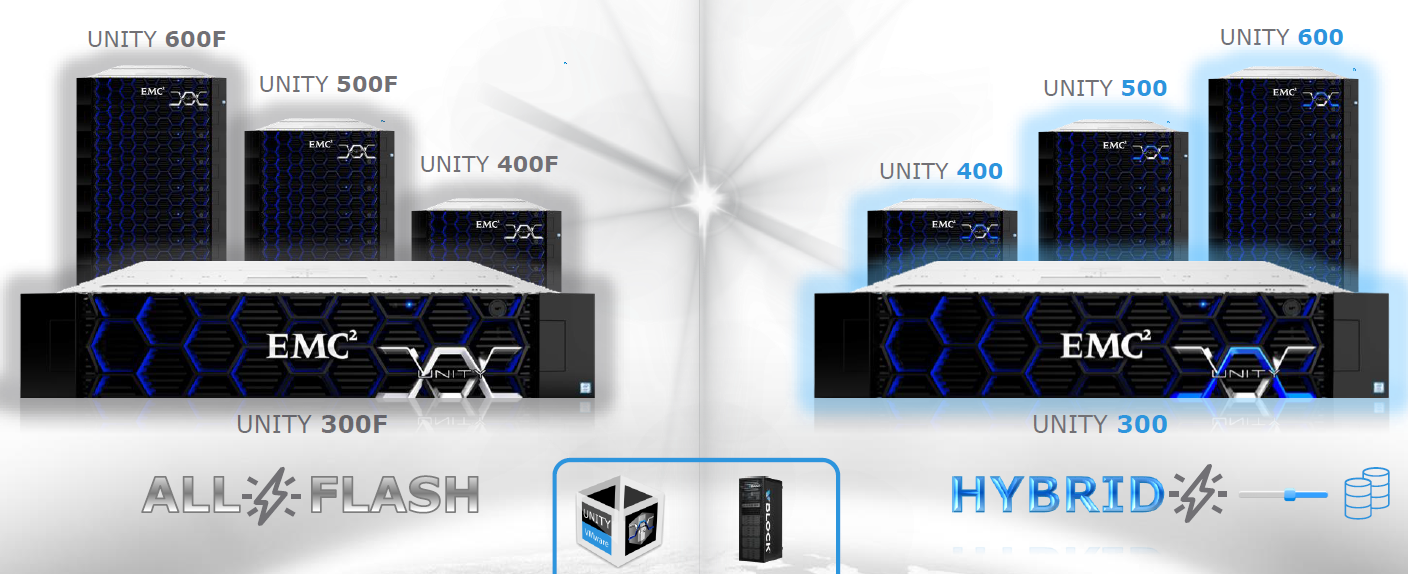

Линейка

У хорошего джедая меч синий, а у очень хорошего — серебистый: обратите внимание на логотипы. За внимание к деталям производителю отдельный плюс в карму.

Тесты

Тестировали стандартным в последнее время для нас методом от rpokruchin.

Результаты получились следующие:

1. Начнем с характерных для SSD нагрузок – случайного чтения и записи. Выделил значения, которые можно принять за эталон. Кстати, видно, что система внутри себя работает блоком 8К, т.к. количество IOPS начинает уменьшаться только при бОльшем размере, а на меньших показывает практически тот же результат. Если подходить к вопросу строго, то результат на случайном чтении – 63,5 тысячи IOPS (когда принимаем 1мс за отсечку и всё, что выше — не в счет). Если на это внимание не акцентировать, то можно считать, что 86 тысяч мы из нее выжали. Хотя каждый волен решать сам, какие результаты считать правильными. Для этого и приведена вся таблица на разных блоках и очередях:

Что интересно, на случайной записи результаты оказались лучше, чем мы думали. Производительность получилась хуже только на 20%. Может быть, конечно, кэш СХД отработал на пятерку, хотя всячески старались его обойти разве только что не выключали. Но это было бы неверно, т.к. его не для того включили в дизайн, чтобы лихие парни из КРОКа его гасили. Да и в продуктиве всё равно он будет включен.

Не оставили без внимания также нагрузки при бэкапах, когда идет последовательное чтение большим блоком и важна скорее пропускная способность, нежели время отклика и иопсы (кто захочет кинуть в меня кирпичом, заранее соглашусь, что да, при бэкапах блок может быть еще больше, но общей картины это не меняет):

И, наконец, нагрузка, характерная для заливки данных — последовательная запись большими блоками.

Из таблицы можно заметить, что после определенного момента производительность уже не растет, а вот время отклика увеличивается. Тут приходится вспомнить, что всё-таки система мидрейнджовая, и звезд с небес не обещала. Тем более на 9 дисках, из которых 4 системных (Да, мы плохие ребята, не следуем своим же лучшим практикам). Просто нужно знать с самого начала ее потолок и следить за своим продуктивом. Чем выше модель в линейке — тем выше её потолок. Он, кстати, почти честно указан в даташите (есть в ссылках ниже). Это нужно учитывать при покупке.

Что интересно, конечно, на высокие показатели она выходит на небольшом количестве дисков — с увеличением количества дисков она быстро упрется в обозначенный потолок и дальше производительность расти не будет, но зато за свои деньги работает. Как мы поняли — причина в том, что система упирается в мощность контроллера. На логичный вопрос был получен ответ — за все в этой жизни надо платить. В случае если нужна производительность больше — нужна большая модель.

Конечно, когда смотришь на свободные слоты для плашек памяти на материнке, хочется добавить туда несколько серверных планок по несколько сотен долларов и получить дополнительный кэш (кэш там – обычные DIMM по 16 Gb). Или поменять процессоры тоже заодно (в младшей модели шестиядерные 1,6 Ггц). Но такое действие снимет желзку и гарантии сразу, увы. Правда, я знаю человека, который как-то умудрился снять со своей СХД систему магнитного уничтожения дисков и выдать полный отказ за гарантийный случай, поэтому, может, кто-то их и будет переставлять перед приездом инженеров, но что-то маловероятно.

Интерфейс

Теперь на HTML 5. GUI отлично работает на Windows и Linux, для ценителей автоматизации есть cli и REST API. Очень много сил было приложено к оптимизации. Выполнение задач реально легче. Удобные визарды пришли на смену беготне по нескольким вкладкам. Realt-time и историческую статистику производительности можно смотреть в онлайн режиме без использования дополнительных утилит. Графики настраиваются в том же интерфейсе, управление очень гибкое.

Помимо административных задач очень упростились сервисные операции. Все они теперь собраны в одной вкладке. Логи с массива собираются быстрее и сразу с обоих контроллеров. В Web GUI появились такие операции как Reimage и обновление кода массива \ дисков.

Есть управление из облака: при желании можно зарегаться в специальном сервисе, куда система будет сливать свои счетчики — будут предлагаться советы по оптимизации ресурсов и управлению. Сделано это, конечно, для того, чтобы вы не пропустили апргейд и дозакупку железа, но, вроде, польза тоже есть.

Есть еще классные тулзы у партнеров по оценке текущей инфраструктуры — можно собрать логи с ваших массивов, проанализировать и на выходе узнать, какая Юнити с учетом роста на 3-5 лет заменит все текущие массивы. И плюс к этому можно понять, нужен ли allflash или гибридной достаточно.

С виртуальной Unity можно поиграть — она скачивается в виде демки с лицензией на некоммерческое использование бесплатно по этой ссылке.

Резюме

Производитель поставил себя на место заказчика и учел свои ошибки: выпустил достойную по производительности хранилку, упростил интерфейс и лицензирование и обеспечил прогнозируемую стоимость владения за счет фиксированной стоимости поддержки.

В дополнение к традиционно высокому качеству продуктов и сервиса можно смело говорить, что система достойна внимания корпоративных заказчиков практически любого уровня. Единственный вопрос — что будет с EMC в свете объединения с Dell. Лично я думаю, что всё так и останется, но это, как говорится, одному Деллу известно.

Вот так сейчас может выглядеть 100Тб флеша

Система была выпущена в мае, у нас есть положительный опыт месячных тестов и внедрения у заказчиков (один из примеров выше). По секрету скажу, что помимо тестовой мы «под шумок» еще купили для своей инфраструктуры одну гибридную и одну флешовую систему и уже эксплуатируем их под внутренние задачи.

Ссылки

- Старый обзор VNX

- EMC ScaleIO – упомянутая программно-определяемая СХД

- Моя почта для вопросов и для запроса акционных цен (увы, каждого участника EMC согласовывает под промо-цены отдельно, поэтому процедура такая нетривиальная) – vbolotnov@croc.ru

- Ну и для любителей даташитов: флешовой и гибридной линеек систем хранения